bwUniCluster

|

Das SCC hat am 27.1.2014 im Rahmen des baden-württembergischen Umsetzungskonzepts für Hochleistungsrechnen, bwHPC, unter der Bezeichnung „bwUniCluster“ einen Parallelrechner als Landesdienst in Betrieb genommen. Am 2.5.2017 ist eine Erweiterung des Clusters in Betrieb genommen worden, die als Bestandteil des bwUniCluster 2.0 weiterlebt. Das erweiterte HPC-System bestand aus mehr als 860 SMP-Knoten mit 64-bit Xeon Prozessoren von Intel. Der Parallelrechner diente der Grundversorgung der Universitäten des Landes Baden-Württemberg mit Rechenleistung und konnte von den Mitarbeiterinnen und Mitarbeitern aller Universitäten in Baden-Württemberg unentgeltlich genutzt werden. Am 10.3.2020 ging der ältere Teil des HPC-Systems außer Betrieb.

|

|

Die Zugangsberechtigung zu diesem System regelte jede Landesuniversität für ihre Mitarbeiter/innen selbst. KIT-Angehörige erhielten die Zugangsberechtigung durch eine separate Freischaltung ihres KIT-Accounts, die mit einem entsprechenden Formular beim Service Desk beantragt wurde. Das Formular konnte über die ServiceDesk-Webseite heruntergeladen werden.

Konfiguration des bwUniCluster

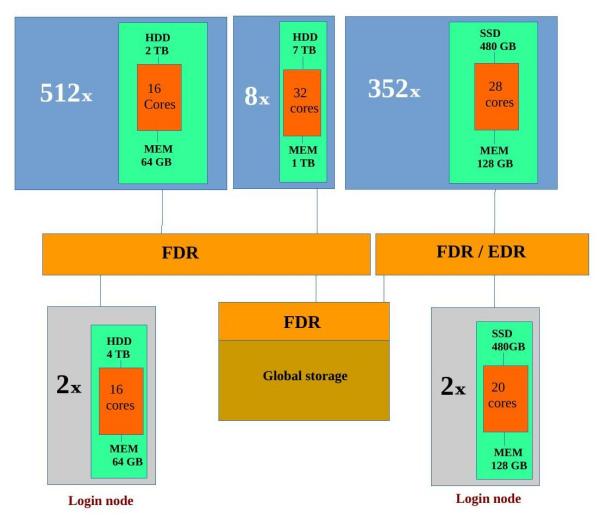

Der bwUniCluster beinhaltete

- 2 Login-Knoten mit jeweils 16 Cores in "Sandy Bridge"-Architektur mit einer theoretische Spitzenleistung von 332,8 GFLOPS und 64 GB Hauptspeicher pro Knoten,

- 2 Login-Knoten mit jeweils 28 Cores in "Broadwell"-Architektur und 128 GB Hauptspeicher pro Knoten,

- 512 "dünne" Rechenknoten (Sandy Bridge) mit jeweils 16 Cores mit einer theoretische Spitzenleistung von 332,8 GFLOPS und 64 GB Hauptspeicher pro Knoten,

- 352 Rechenknoten (Broadwell) mit jeweils 28 Cores mit einer theoretischen Spitzenleistung von ca. 770 GFLOPS und 128 GB Hauptspeicher pro Knoten,

- 8 "fette" Rechenknoten (Sandy Bridge) mit jeweils 32 Cores mit einer theoretische Spitzenleistung von 614,4 GFLOPS und 1 TB Hauptspeicher pro Knoten

- und als Verbindungsnetzwerk ein InfiniBand 4X FDR Interconnect.

Der bwUniCluster war ein massiv paralleler Parallelrechner mit insgesamt 886 Knoten, wobei 10 Knoten davon Service-Knoten waren. Dabei waren die Fileserver-Knoten nicht mitgezählt. Alle "Sandy Bridge"-Knoten - bis auf die "fetten" Knoten - hatten eine Taktfrequenz von 2,6 GHz. Die "fetten" Knoten hatten eine Taktfrequenz von 2,4 GHz. Alle Knoten besassen lokalen Speicher, lokale Platten und Netzwerkadapter. Ein einzelner "Sandy Bridge"-Rechenknoten hatte eine theoretische Spitzenleistung von 332,8 bzw. 614,4 GFLOPS und ein einzelner "Broadwell"-Rechenknoten hatte eine theoretische Spitzenleistung von ca. 770 GFLOPS, so dass sich eine theoretische Spitzenleistung von ca. 444 TFLOPS für das gesamte System ergab. Der Hauptspeicher über alle Rechenknoten hinweg betrug ca. 86 TB. Alle Knoten waren durch ein InfiniBand 4X FDR Interconnect miteinander verbunden.

Das Basisbetriebssystem auf jedem Knoten war ein Red Hat Enterprise Linux (RHEL) 7.x. Als Managementsoftware für den Cluster diente KITE; KITE ist eine offene Umgebung für den Betrieb heterogener Rechencluster.

Als globales Dateisystem war das skalierbare, parallele Dateisystem Lustre über ein separates InfiniBand Netzwerk angebunden. Durch die Nutzung mehrerer Lustre Object Storage Target (OST) Server und Meta Data Server (MDS) wird sowohl eine hohe Skalierbarkeit als auch eine Redundanz beim Ausfall einzelner Server erreicht. Im HOME-Verzeichnis standenKIT-Mitarbeitern ca. 425 TiB an Plattenplatz zur Verfügung, wobei den Benutzern aus Baden-Württemberg noch einmal die gleiche Menge an Plattenplatz als HOME-Verzeichnis zur Verfügung gestellt wurde. Im WORK-Verzeichnis standen ca. 850 TiB an Plattenplatz zur Verfügung; für Workspaces gab es weitere 850 TiB an Plattenplatz. Daneben war jeder Knoten des Clusters mit lokalen Platten für temporäre Daten ausgestattet.

Detaillierte Kurzbeschreibung der Knoten:

- 2 16-Wege (Login-)Knoten mit jeweils 2 Octa-Core Intel Xeon E5-2670 Prozessoren (Sandy Bridge) mit einer Taktfrequenz von 2,6 GHz, 64 GB Hauptspeicher und 4 TB lokalem Plattenplatz,

- 2 20-Wege (Login-)Knoten mit jeweils 2 10-Core Intel Xeon E5-2630 v4 Prozessoren (Broadwell) mit einer Standard-Taktfrequenz von 2,2 GHz, 128 GB Hauptspeicher und 480 GB lokaler SSD,

- 512 16-Wege (Rechen-)Knoten mit jeweils 2 Octa-Core Intel Xeon E5-2670 Prozessoren (Sandy Bridge) mit einer Taktfrequenz von 2,6 GHz, 64 GB Hauptspeicher und 2 TB lokalem Plattenplatz,

- 352 28-Wege (Rechen-)Knoten mit jeweils 2 14-Core Intel Xeon E5-2660 v4 Prozessoren (Broadwell) mit einer Standard-Taktfrequenz von 2,0 GHz, 128 GB Hauptspeicher und 480 GB lokaler SSD,

- 8 32-Wege (Rechen-)Knoten mit jeweils 4 Octa-Core Intel Xeon E5-4640 Prozessoren (Sandy Bridge) mit einer Taktfrequenz von 2,4 GHz, 1 TB Hauptspeicher und 7 TB lokalem Plattenplatz und

- 10 16-Wege Service-Knoten mit jeweils 2 Octa-Core Intel Xeon E5-2670 Prozessoren mit einer Taktfrequenz von 2,6 GHz und 64 GB Hauptspeicher.

Ein einzelner Octa-Core Prozessor (Sandy Bridge) hatte 20 MB L3-Cache und betrieb den System Bus mit 1600 MHz, wobei jeder einzelne Core des Sandy Bridge Prozessors 64 KB L1-Cache und 256 KB L2-Cache hatte.

Ein einzelner 14-Core Prozessor (Broadwell) hatte 35 MB L3-Cache und betrieb den System Bus mit 2400 MHz, wobei jeder einzelne Core des Sandy Bridge Prozessors 64 KB L1-Cache und 256 KB L2-Cache hatte.

Zugriff auf den bwUniCluster für Mitarbeiter(innen) des KIT

Nur sichere Verfahren wie secure shell (ssh) und die zugehörige secure copy (scp) waren erlaubt beim Einloggen bzw. beim Kopieren von Daten von und zum bwUniCluster. Die Mechanismen telnet, rsh sowie weitere r-Kommandos waren aus Sicherheitsgründen abgeschaltet. Um sich auf dem bwUniCluster (uc1 oder uc1e) einzuloggen, sollte das folgende Kommando benutzt werden:

ssh kit-account@bwunicluster.scc.kit.edu (oder auch ssh kit-account@uc1.scc.kit.edu) # "Sandy Bridge"-Architektur

ssh kit-account@bwunicluster-broadwell.scc.kit.edu (oder auch ssh kit-account@uc1e.scc.kit.edu) # "Broadwell"-Architektur