Supercomputing News

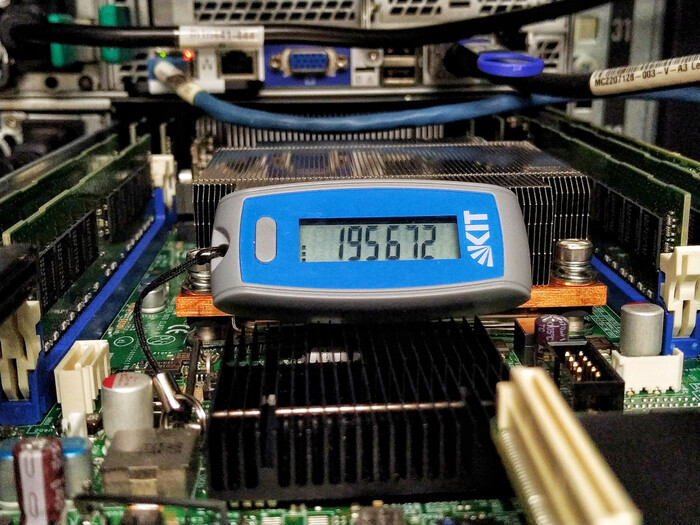

Am 14.9.2023 feierte das KIT mit einem Festkolloquium die in Karlsruhe schon 40 Jahre umspannende Ära des Hochleistungsrechnens. Die geladenen Gäste konnten sich über die gesamte Bandbreite des HPC in Karlsruhe informieren und austauschen.

Am 14. September 2023 feierte das SCC mit einem internen Festkolloquium die in Karlsruhe schon 40 Jahre umspannende Ära des Hochleistungsrechnens. Die geladenen Gäste aus Forschungspolitik und -management, Rechenzentrumsplanung, -bau und -betrieb sowie Wissenschaftlerinnen und Wissenschaftler, ehemalige wie auch aktive, konnten sich bei Vorträgen, Paneldiskussion sowie Ausstellung und Führungen aus erster Hand über die gesamte Bandbreite von 40 Jahren Hochleistungsrechnen in Karlsruhe informieren. Es gab viel Raum Erfolge und Herausforderungen revuepassieren zu lassen, ein wenig über die Zukunft zu philosophieren, und natürlich, um gemeinsam zu feiern und interessante Geschichten auszutauschen.

Der für HPC zuständige Referatsleiter im Ministerium für Wissenschaft, Forschung und Kunst Baden-Württemberg (MWK), Peter Castellaz, hob in seinen Grußworten die Landesstrategie bwHPC heraus, mit der das SCC nicht nur wichtige inhaltliche Aspekte umgesetzt, sondern sich in einer intensiv gelebten Kooperationskultur federführend engagiert hat. „Neben den HPC-spezifischen Ressourcen und dem zugehörigen Methodenwissen hat sich das KIT besonders mit seiner Expertise im Bereich Daten und Forschungssoftware erfolgreich eingebracht“ so Peter Castellaz. Lobende Worte findet er zum landesweiten föderierten Identitätsmanagement bwIDM, mit dem das SCC gemeinsam mit anderen Landeseinrichtungen entscheidende Grundvoraussetzungen für kooperativ erbrachte Dienste – auch über das HPC hinaus – erarbeitet hat. Um neben technologischen Entwicklungen auch die Themen Forschungssoftware und Nachhaltigkeit zu akzentuieren, wird eine umfassende Landesstrategie bis zum Jahr 2032 erarbeitet, lässt Peter Castellaz wissen.

Die KIT-Vizepräsidentin für Digitalisierung und Nachhaltigkeit, Kora Kristof, zeigt sich in ihren Grußworten beeindruckt von der Community, die sich über lange Zeit im HPC-Umfeld entwickelte, vom Gauß Centre for Supercomputing (GCS) angefangen, über die unterschiedlichen Zentren der Ebenen Tier-2 (Gauß-Allianz) und Tier-3, national und in Baden-Württemberg. „Was im Bereich des HPC vom KIT und anderen Einrichtungen auf Landesebene entwickelt wurde, hat auch die Entwicklungen national mitgeprägt und dafür gilt ein besonderer Dank“, stellt Kora Kristof fest. Zudem habe das KIT das Hochleistungsrechnen mit dem Thema Energieeffizienz verbunden und damit herausragende Erfolge erzielt. Hier sprechen der Deutsche Rechenzentrumspreis 2017 für ForHLR II und Platz 13 auf der internationalen Bestenliste der energieeffizientesten Rechner für HoreKa für sich. „Und zukünftig werden uns auch im HPC-Umfeld noch viele interessante Themen, die Nachhaltigkeit prägen, beschäftigen – dies betrifft nachhaltige Gebäude und Infrastrukturen, den Einsatz nachhaltiger Materialien und Ressourcenschonung sowie Aspekte der nachhaltigen Software“ prognostiziert Kora Kristof.

In der Überleitung zu den Fachvorträgen charakterisiert Martin Frank, Direktor des SCC, das HPC-Geschäft als eine Mischung aus etwas sehr Dynamischem und etwas Konservativem. „Das Dynamische ist an der Entwicklung von HPC-Systemen in den letzten 40 Jahren sehr deutlich zu erkennen, das Konservative steckt beispielsweise in der Bearbeitung sehr komplexer Prozesse wie Beschaffung und dem sicheren Betrieb der Infrastruktur“, konkretisiert Martin Frank in seinem Grußwort und weiß, dass Erfahrung und Innovation die wichtigen Pole im HPC-Geschäft sind, die das SCC im Nationalen Hochleistungsrechnen zu einer wichtigen Größe machen. „All das sorgt dafür, dass Wissenschaftlerinnen und Wissenschaftler in Ihrer Forschung mit Hochleistungsrechnern und Forschungssoftware bestmöglich unterstützt werden.“

Eric Schnepf führte im ersten Fachvortrag in die Anfänge der Hochleistungsrechner in Karlsruhe ein und spannte einen Bogen über die Entwicklungen bis hin zur Gegenwart. Er machte seine ersten IT-Erfahrungen in den 70er-Jahren an der Universität Karlsruhe mit Algol-Programmen, die er mittels eines Siemens T100 Fernschreibers auf Lochstreifen erstellte und auf der Zuse Z 23 zum Ablauf brachte. In den 80ern konnte er sich neben den Universalrechnern auch mit Vektorrechnern vertraut machen, auf denen man Anwendungen genauer und schneller berechnen konnte. Den Beginn der HPC-Ära in Karlsruhe datiert Eric Schnepf auf Mai 1983, wo ein Landesvektorrechner, eine Cyber 205, nach vorherigen Tests an einer gleichartigen Maschine der Uni Bochum im Universitätsrechenzentrum in Karlsruhe installiert und betrieben wurde. Die Betreuung der Anwender erfolgte durch ein Team aus Uni Karlsruhe und dem damaligen Kernforschungszentrum Karlsruhe (KfK). „Die Beschaffung kam nur zustande, weil eine große Community sehr gut zusammenarbeitete: Uni, KfK und Industriepartner“ bekräftigt Eric Schnepf in seinem Vortrag. Neben vielen interessanten technischen Ausflügen in die Welt der damals in der Uni installierten Rechnersysteme, führte Eric Schnepf auch Anwendungsbeispiele an – beispielsweise aus der Klimaforschung – und ging auf die zwischen Siemens-Nixdorf und der Uni geschaffenen Kooperation ODIN ein, was für Optimale Datenmodelle und Algorithmen für Ingenieur- und Naturwissenschaften auf Hochleistungsrechnern steht. Ein Meilenstein war die erste TOP500-Liste der Supercomputer, die im Jahr 1993 erschien. Das Original-Handout zeigt die Deutschlandliste mit den beiden erstplatzierten Systemen vom Typ S600/20 aus Karlsruhe und Aachen. Seinen Vortrag rundete Eric Schnepf mit einer Übersichtsfolie der wichtigsten HPC-Systeme der letzten 40 Jahre in Karlsruhe ab und ordnet diese in die Grenzlinien der TOP500 (Platz 1 .. Platz 500) ein. „Von der Cyber 205 (1983) bis HoreKa (2023) sind das acht Zehnerpotenzen Leistungssteigerung, also im Schnitt alle 10 Jahre Faktor 100 Beschleunigung. Ich denke, das kann sich sehen lassen“, wertschätzt Eric Schnepf die Entwicklung im HPC in Karlsruhe.

Klaus-Peter Mickel, Physiker und ehemaliger Direktor des SCC, war schon Ende der 60er-Jahre als Programmierer für die IBM-Maschinen am Rechenzentrum des Forschungszentrums Karlsruhe (FZK) tätig und erlebte und gestaltete ebenfalls die Entwicklungen der Hochleistungsrechenanlagen in Karlsruhe von Anfang an mit. Als er 1970 eine Stelle am Rechenzentrum Karlsruhe annahm, übernahm er die Betreuung der Uni-Mitarbeitenden, die die Maschinen des FZK benutzen wollten. Nach verschiedenen beruflichen Stationen hat Klaus-Peter Mickel 1996 dann die Leitung des Rechenzentrums am FZK angetreten. In seinem Rückblick auf die Jahre zwischen 1966 und 1996 schildert Klaus-Peter Mickel die intensive Kooperation der Computerfachleute in Uni und FZK, die schließlich, ab 1996, zur Planung einer ausgeklügelten technischen und organisatorischen Kooperation beider wissenschaftlicher Rechenzentren führte – das Virtuelle Rechenzentrum Karlsruhe wurde gegründet. Virtuell, ja, denn es kam nämlich nicht, wie ursprünglich überlegt, zu einem gemeinsamen Rechenzentrum beider Institutionen an einem Standort, sondern zu einem Verbund mit einer juristisch abgesicherten Kooperationsvereinbarung. Es gab ein gemeinsames Leitungsgremium und unterschiedliche Architekturschwerpunkte auf beiden Seiten, jeweils mit gegenseitig eingebrachten Ressourcen. Die Uni legte ihren Schwerpunkt auf die massiv parallelen Rechner und das FZK auf die damals sehr leistungsfähigen Vektorrechner. Eine eigens dafür gelegte Datenleitung verband über 10 km Luftlinie beide Rechenzentren und erreichte damals die respektable Geschwindigkeit von 155 Megabit pro Sekunde. Durch die Einrichtung des Virtuellen Rechenzentrums wurden viele positive Effekte erzielt. Neben einer hohen Effizienz, weil nicht beide Seiten beide Architekturen zu betreuen hatten entstand ein großer Nutzen für die Anwendergruppen, weil sie beide Architekturen zur Verfügung hatten.

Rudolf Lohner gab in seinem Vortrag einen intensiven Einblick in die Entstehung des Rechenzentrums der Uni und der damit verbundenen Entwicklung sowie den Betrieb der massiv parallelen Rechner in Karlsruhe, der sogenannten Rechencluster. Rudolf Lohner war 20 Jahre Mitarbeiter bei den Mathematikprofessoren Alefeld und Kulisch, die er als Wegbereiter der ersten Stunden und Gründer des Hochschulrechenzentrums würdigte. Er ist dann in den 2000er Jahren vom Mathematikinstitut ans Rechenzentrum der Uni Karlsruhe gewechselt und war bis zum Ende seiner aktiven Tätigkeit Experte für Energieeffizienz in Hochleistungsrechenzentren am SCC. Mitte der 90er haben sich zunehmend die massiv parallelen Rechencluster etabliert und auch am Rechenzentrum der Uni wurden solche Systeme über die letzten Jahre, bis heute, für die Forschung betrieben. Rudolf Lohner stellte in einem kurzweiligen Streifzug nicht nur die verschiedenen Clustersysteme vor, sondern auch einige wichtige Projekte und Anwendungsszenarien. Das Spektrum geht von der mathematischen Simulation von Segelbooteigenschaften für den America’s Cup, über die Erstellung von präzisen Wettervorhersagen bis hin zur Entwicklung institutseigener Clustermanagementsysteme. Für den heute am SCC betriebenen Hochleistungsrechner Karlsruhe (HoreKa) und dessen Vorgängersysteme ForHLR I und ForHLR II entwarf Rudolf Lohner gemeinsam mit dem HPC-Team das äußerst effiziente Energie- und Betriebskonzept. Der dazugehörige Neubau wurde 2015 fertiggestellt und beherbergt am Campus Nord des KIT deutschlandweit nutzbare HPC-Systeme. Vor ein paar Monaten wurden die notwendigen baulichen und technischen Vorbereitungen abgeschlossen, um das Gebäude auch für zukünftige, noch viel leistungsfähigere Rechensysteme mit bis zu 2 Megawatt Leistungsaufnahme fitzumachen.

Im Anschluss an die spannenden Fachvorträge, die die gesamten 40 Jahre HPC in Karlsruhe aus verschiedenen Blickwinkeln beleuchteten, konnten die Gäste an Führungen durch die HPC-Infrastruktur teilnehmen sowie in einem eigens dafür eingerichteten Ausstellungsraum Rechenzentrumsexponate der letzten 40 Jahre bewundern.

Das SCC bedankt sich beim Ministerium für Wissenschaft, Forschung und Kunst Baden-Württemberg, dem Präsidium des KIT, bei allen Beteiligten, die 40 Jahre HPC in Karlsruhe gestaltet haben und konsequent weiterentwickeln sowie dem Organisationsteam dieses Festkolloquiums um Simon Raffeiner (s. Foto) und natürlich bei allen seinen Gästen.

Achim Grindler

Fotos: Markus Breig (KIT)

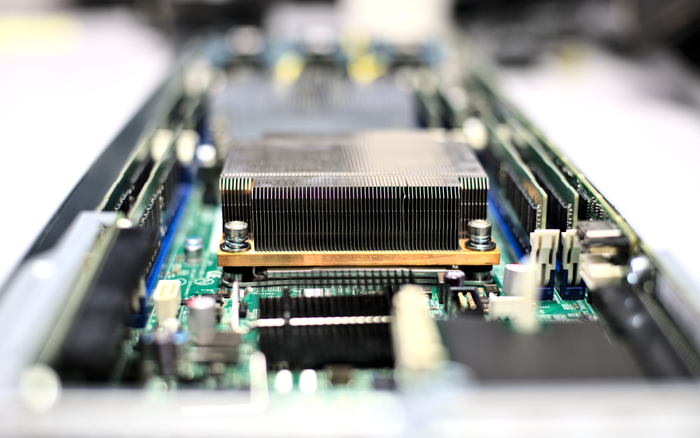

Das Tier-1 Zentrum des Worldwide LHC Computing GridKa baut massiv seinen Speicherplatz aus. Es stehen weitere neu installierte 71 Petabyte Onlinespeicher zur Verfügung. Die Datenmigration ist nun für fast alle Experimente abgeschlossen.

Im Frühjahr 2023 wurde die Erweiterung des Onlinespeichersystems für das GridKa Tier-1 Zentrum im Worldwide LHC Computing Grid am KIT in Betrieb genommen. Die neu installierten 71 Petabyte stehen den LHC-Experimenten ALICE, ATLAS, CMS, LHCb und den Experimenten Belle-II, Pierre Auger Observatory, Icecube und DARWIN zur Verfügung und ersetzen auch 30 Petabyte Speicherhardware, die nach sechs Jahren außer Betrieb genommen werden. Ingesamt verfügt GridKa jetzt über 99 Petabyte Onlinespeicher.

Leider verzögerte sich die Inbetriebnahme durch die Chip- und Logistikkrise nach der Corona-Pandemie und dem Ukrainekrieg um ein Jahr. Die neue Installation besteht aus hoch-dichten Seagate CORVAULT-Systemen mit insgesamt 4664 18-Terabyte-Festplatten, 70 Servern und Infiniband-Switches, die in die vorhandenen Infiniband-Netzwerk-Fabrics eingebunden wurden. Als software-defined Storage-Ebene kommt IBM Storage Scale zum Einsatz. Die vorhandenen Dateisysteme wurden nicht erweitert, sondern neue Dateisysteme angelegt. Damit können neue NVMe-basierte Metadaten-Speichersysteme eingesetzt und neue Features von IBM Storage Scale genutzt werden. Die Daten sind für fast alle Experimente bereits migriert und die Systeme im Produktivbetrieb.

Kontakt am SCC: Dr. Serge Sushkov

Achim Grindler

Propulate ist eine Software, die ganz allgemeine Optimierungsprobleme mit Hilfe von genetischen Algorithmen löst. Sie ist speziell für High-Performance-Systeme ausgelegt, einfach zu bedienen und steht der Allgemeinheit zur Verfügung.

Mit Propulate stellt das SCC eine Software zur Verfügung die Optimierungsproblemen mit Hilfe von genetischen Algorithmen löst. Propulate ist speziell für High-Performance-Systeme ausgelegt und steht zur allgemeinen Nutzung zur Verfügung und ist einfach zu benutzen. Propulate ist schneller und sogar akkurater als ein herkömmlicher Algorithmus, in typischen Benchmarks meist eine ganze Größenordnung.

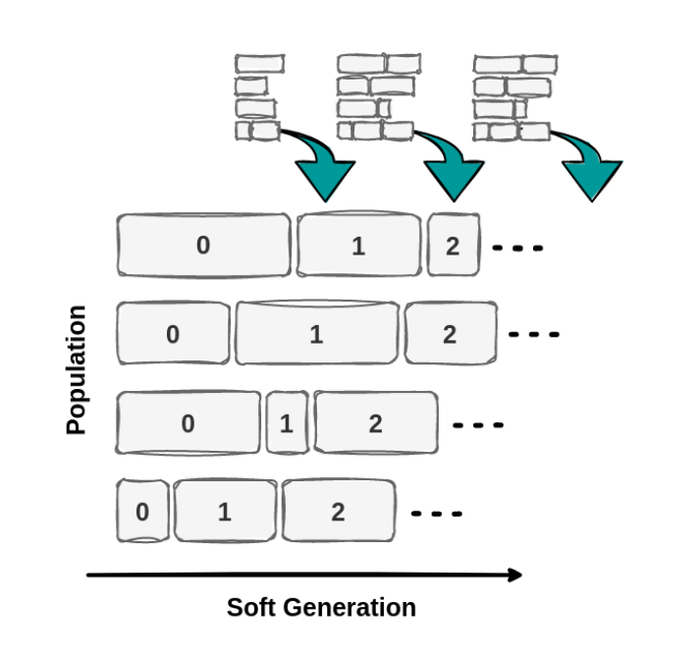

Propulate ist von der Natur und speziell von der genetischen Auslese in der Evolution inspiriert. Die Evolution beginnt in der Regel mit einer Population von zufällig erzeugten Lösungskandidaten und ist ein iterativer Prozess. Die Population in jeder Iteration wird als Generation bezeichnet. In jeder Generation wird die Fitness jedes einzelnen Individuums in der Population bewertet. Die Gene der fittesten Kandidaten gehen in die neue Generation ein. Wie in der Natur warten wir nicht ab, bis alle Recheneinheiten fertig sind. Stattdessen kommunizieren die Recheneinheiten untereinander und bearbeiten das Problem mit der momentanen Gesamtpopulation sofort weiter. Damit wird im Vergleich zu anderen Ansätzen eine Lastimbalance vermieden (s. Erklärvideo).

Jeder Knoten ist für die Berechnung eines Lösungskandidaten zuständig. Das Ergebnis dieser Rechnung ist ein neuer Kandidat, der aus Genen und einem dazugehörendem Fitnesslevel besteht. Die Gene sind dabei die Attribute, die den Lösungskandidaten vollständig beschreiben, der Fitnesslevel ist ein Maß mit dem sich die Kandidaten vergleichen lassen. Diese Informationen werden dann an alle Recheneinheiten weitergegeben.

Wenn eine Recheneinheit die Evaluierung eines Kandidaten abgeschlossen hat, benutzt sie die Fitnesswerte der gesamten bisherigen Population um einen neuen Lösungskandidaten zu erzeugen. Das Verfahren kann zur Neural Architecture Search oder ganz allgemein zur Hyperparametersuche verwendet werden. Damit ist Propulate ein Werkzeug, um die Suche nach passenden Netzen zu ermöglichen. Anwendungen, in denen Propulate bereits zum Einsatz gekommen ist, sind beispielsweise elektrische Netzlastvorhersage, Satellitenfernerkundung, und molekulare Strukturbiologie.

Weitere Informationen:

Propulate Code Repository

Erklärvideo

Paper Massively Parallel Genetic Optimization through Asynchronous Propagation of Populations

Kontakt am SCC: Dr. Marie Weiel, Oskar Taubert

Achim Grindler

Forschende der Plattform Helmholtz AI aus dem SCC und dem JSC haben erneut ihre Ergebnisse gemeinsam in die MLPerf™ HPC Benchmarking Suite eingebracht und konnten so zeigen, dass ihre HPC-Systeme mit den leistungsfähigsten KI-Chips arbeiten.

Die rasante Entwicklung von KI-Methoden und -Tools kann es schwierig machen, mit den real verfügbaren Möglichkeiten der Computertechnologie Schritt zu halten und noch schwieriger ist es, die beste Wahl für eine bestimmte KI-Aufgabe zu treffen. Aus diesem Grund sind Benchmarking-Werte der Schlüssel zum Vergleich und damit zur Auswahl der besten verfügbaren Option für KI Probleme. Benchmarking-Plattformen geben unter anderem einen Gesamtüberblick über relevante Aspekte wie Leistung, Umweltauswirkungen, Effizienz und Trainingsgeschwindigkeit.

Aus diesem Grund haben Forschende der Plattform Helmholtz AI aus dem Scientific Computing Center (SCC) am Karlsruher Institut für Technologie (KIT) und dem Jülich Supercomputing Centre (JSC) am Forschungszentrum Jülich wie im vergangenen Jahr ihre Ergebnisse gemeinsam in die MLPerf™ HPC Benchmarking Suite eingebracht. Die Gruppe ist stolz zu verkünden, dass die HPC-Infrastrukturen an deren Helmholtz-Zentren mit den leistungsfähigsten KI-Chips ausgestattet sind.

Die Helmholtz-KI-Mitglieder Daniel Coquelin, Katharina Flügel und Markus Götz vom SCC sowie Jan Ebert, Chelsea John und Stefan Kesselheim vom JSC koordinierten gemeinsam die Einreichung. Die Ergebnisse beziehen sich auf beide Einheiten in diesen Zentren: den Supercomputer HoreKa am SCC und den JUWELS Booster am JSC. Beide sind mit Beschleunigern vom Typ NVIDIA A100 ausgestattet, die laut Benchmark die beste Leistung erbringen. Der JUWELS Booster verwendete für diese Messungen sogar bis zu 3.072 NVIDIA A100 GPUs.

Die MLPerf™ HPC-Benchmarking-Suite bietet den Wissenschaftlerinnen und Wissenschaftlern eine großartige Gelegenheit code- als auch systembasierte Optimierungsmethoden und -werkzeuge aufs feinste abzustimmen. So konnten sie die Performance beispielsweise mit dem CosmoFlow-Benchmark (Physical Quantity Estimation From Cosmological Image Data) im Vergleich zum letzten Jahr um über 300 % verbessern. Bei der Feinabstimmung der IO-Operationen fanden sie beispielsweise Möglichkeiten, wie die Dateisysteme eine schnellere und zuverlässigere Lese- und Schreibleistung erbringen können. Dank dieser Ergebnisse erreichte der Supercomputer HoreKa in den jüngsten CosmoFlow-Benchmark-Ergebnissen, die unter anderem in IEEE Spectrum und HPCWire gezeigt wurden, den zweiten Platz hinter NVIDIAs Selene-System und den ersten Platz für Forschungs- und Lehreeinrichtungen in Bezug auf die schnellste Trainingszeit. Dabei konnten sogar größere Systeme wie RIKENs Fugaku übertroffen werden.

Da die Auswirkungen des Klimawandels immer offensichtlicher werden, ist es auch unerlässlich, dass man den ökologischen Fußabdruck bewusster gestaltet, insbesondere im Hinblick auf den Energieverbrauch. Zu diesem Zweck haben die Systemadministratoren von HoreKa den Einsatz des Lenovo XClarity Controllers zur Messung des Energieverbrauchs der Rechenknoten* aktiviert. Für die Einreichungsläufe auf dem HoreKa wurden 1.127,8 kWh verbraucht. Das ist mehr Leistung, als man braucht, um mit einem durchschnittlichen Elektroauto von Portugal nach Finnland zu fahren.

Die MLPerf™ HPC-Benchmarking Suite ist dabei essentiell, um den Nutzen der HPC-Maschinen für moderne KI-Arbeitsabläufe zu ermitteln. Das Helmholtz-AI-Team freut sich darauf, nächstes Jahr wieder mitzumachen.

Kontakt am SCC: Dr. Markus Götz

*Diese Messung umfasst nicht alle Teile des Systems und ist keine offizielle MLCommons-Methode, bietet jedoch einen Mindestmesswert für den Energieverbrauch auf dem System. Da jedes System anders konfiguriert ist, können diese Ergebnisse nicht direkt auf andere Einreichungen übertragen werden.

Achim Grindler

Seit mehr als zwei Jahren betreibt das SCC dedizierte KI-Ressourcen für die KI-Forschung innerhalb der Helmholtz-Gemeinschaft, kurz HAICORE@KIT. Ein neues Betriebsmodell vereinfacht nun den Zugang noch weiter und erhöht die Kapazitäten.

Künstliche Intelligenz (KI) und Maschinelles Lernen (ML) umfassen Technologien, die Industrie, Wissenschaft und Gesellschaft in einer noch nie dagewesenen Art und Weise beeinflussen werden. Sprach- und Bilderkennung sind nur zwei der greifbaren Beispiele für Anwendungen, die sich in den letzten Jahren als zuverlässig einsetzbar erwiesen haben.

HAICORE: Ressourcen für KI/ML

Für die Forschung und Ausbildung in den Bereichen KI und ML werden vor allem große Mengen von Rechenleistung benötigt, die meist mittels GPUs bereitgestellt werden. Um den kurzfristigen Bedarf an KI-Hardware zu befriedigen, wurden mit den “Helmholtz AI Computing Resources” (HAICORE) sowohl am SCC (HAICORE@KIT) als auch am Forschungszentrum Jülich (HAICORE@FZJ) dedizierte Hardware-Plattformen für alle an KI Forschenden der Helmholtz-Gemeinschaft geschaffen.

HAICORE@KIT ist dabei mit seinen 72 GPUs vom Typ NVIDIA A100-40 vor allem auf einen prototypischen Nutzungsmodus der Ressourcen, z.B. für die interaktive Verwendung mit Jupyter, und einen möglichst einfachen Zugang ausgerichtet. Für Projekte mit einem höheren Bedarf stehen neben HAICORE@FZJ auch die großen GPU-Systeme wie z.B. HoreKa am SCC zur Verfügung.

Selbstregistrierung und mehr Kapazitäten

Der Zugang zu HAICORE@KIT war zwar bereits sehr niederschwellig, erforderte aber einige manuelle Schritte wie das Ausfüllen eines kurzen Antragsformulars oder die Pflege von Gäste- und Partner-Accounts für alle Nutzenden, die nicht dem KIT angehören.

Zum 22.09.2022 wurde daher das bisherige Betriebsmodell geändert. Mitarbeiter aller 18 Helmholtz-Institutionen können sich nun über die Helmholtz-AAI mit ihren gewohnten Konten beim Federated Login Service (FeLS) des SCC anmelden und sich dort selbst für den neuen Dienst HAICORE@KIT registrieren. Der Zugriff auf bis zu vier GPUs gleichzeitig pro Job ist damit sofort freigeschaltet. Eine Erhöhung dieses Limits ist auf Anfrage möglich.

Neu kommt nun auch das Feature “Multi Instance GPU” (MIG) zum Einsatz um die Kapazität von HAICORE@KIT weiter zu erhöhen. Dieses erlaubt es mehreren Nutzenden den gleichzeitigen Zugriff auf die gleiche GPU, ohne dass sich Prozesse gegenseitig beeinflussen.

Weitere Informationen zu HAICORE@KIT finden Sie auf der Webseite von Helmholtz AI oder in der Nutzerdokumentation.

Simon Raffeiner

Das neue NVIDIA-Arm-Cluster reiht sich in eine stetig weiter wachsende Zahl von Entwicklungssystemen für Zukunftstechnologien ein.

Ob im Ingenieurwesen, den Lebenswissenschaften, der Astrophysik oder der Materialforschung – in kaum einem Fachbereich ist Spitzenforschung heute noch ohne leistungsfähige Supercomputer möglich. Das Nationale Hochleistungsrechenzentrum des Karlsruher Instituts für Technologie (NHR@KIT ) betreibt gleich mehrere solcher Systeme für Forschende aus ganz Deutschland.

Der Großteil der weltweit betriebenen Supercomputer setzte im letzten Jahrzehnt auf nur zwei unterschiedliche Hardware-Architekturen von drei verschiedenen Herstellern. Intel und AMD dominieren mit ihrer sogenannten „x86“-Architektur den Markt für Hochleistungsprozessoren (CPUs), die Beschleuniger-Chips (GPUs) stammen fast immer von NVIDIA. Diese „Monokultur“ erleichtert den Nutzenden zwar den Wechsel zwischen den Systemen, andererseits bleibt aber auch das Potential alternativer Architekturen, die möglicherweise eine vielfach höhere Leistung und Energieefizienz erreichen können, ungenutzt.

Um diese Potentiale auszuschöpfen, ist es wichtig, Nutzenden wie auch Betreibern die Möglichkeit zu geben, diese alternativen Architekturen auf einfache Art und Weise und unter realen Bedingungen zu evaluieren. Ein zentraler Bestandteil von NHR@KIT ist daher die sogenannte „Future Technologies Partition“, ein Hard- und Software-Testbett für neuartige, disruptive Technologien die noch keine Marktdurchdringung erreicht haben und in den großen Hochleistungsrechnern deswegen noch nicht verfügbar sind. Zu dieser Kategorie gehören auch Prozessoren mit der Arm-Architektur. Diese Architektur kommt mittlerweile nicht mehr nur in Mobiltelefonen zum Einsatz, sondern beispielsweise auch im derzeit schnellsten Supercomputer der Welt, dem japanischen „Fugaku“, oder in aktuellen Systemen von Apple.

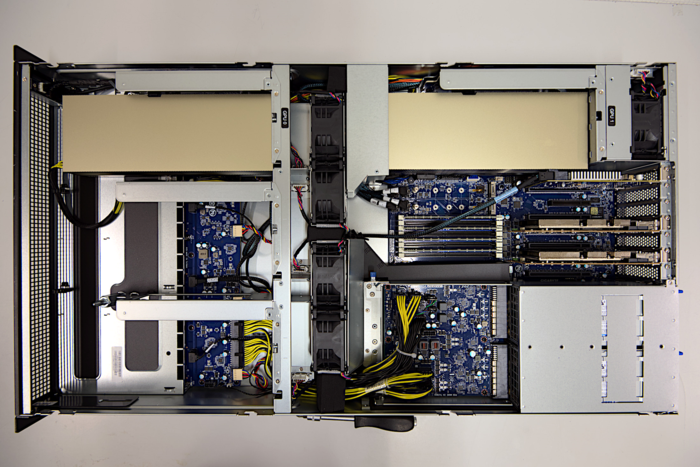

Auch NVIDIA plant für das Jahr 2023 den Einstieg in die Herstellung von Hochleistungsprozessoren auf Basis der Arm-Architektur. Diese sollen zusammen mit der nächsten GPU-Generation (Codename „Hopper“) in zukünftigen Supercomputern zum Einsatz kommen. Um bereits jetzt die Portierung von Anwendungen zu ermöglichen, bietet NVIDIA seinen Partnern spezielle Entwicklungssysteme (NVIDIA Arm HPC Developer Kits) an. Jedes dieser Kits besteht aus einem Arm-Prozessor des Herstellers Ampere mit 80 CPU-Kernen, zwei NVIDIA A100 Beschleunigern und zwei BlueField-2 Data Processing Units (DPU) mit InfiniBand-Anschluss.

Eines der Racks der Future Technologies Partition,

in dem die neuen Systeme installiert wurden.

„Die Übertragbarkeit der in der Future Technologies Partition gewonnenen Ergebnisse ist uns sehr wichtig“, so Simon Raffeiner, Technischer Leiter des HPC-Bereichs bei NHR@KIT. „Die meisten Berechnungen auf den großen Hauptsystemen wie HoreKa laufen auf mehr als nur einem einzigen Serversystem gleichzeitig. Daher hat das KIT als einziger Standort weltweit nicht nur ein einziges NVIDIA Arm Developer Kit beschafft, sondern ein ganzes Cluster. Nur so ist es Nutzenden möglich, ihre Anwendungen unter realistischen und vergleichbaren Bedingungen zu testen.“

Die neuen Systeme reihen sich in eine stetig weiter wachsende Zahl von Entwicklungssystemen in der Future Technologies Partition ein. Dazu gehören beispielsweise auch spezielle Beschleuniger für Künstliche Intelligenz und Machine Learning (KI/ML) des Herstellers Graphcore, bereits existierende Arm-Systeme oder neuartige All-Flash-Datenspeicher.

„Wir versuchen die Systeme soweit möglich symmetrisch auszulegen“, erklärt Raffeiner weiter. „Wenn es beispielsweise ein System mit einer x86-CPU und NVIDIA-GPUs gibt, dann gibt es auch ein System mit einer Arm-CPU und NVIDIA-GPUs.“ Um die aktuelle Matrix der Systeme zu vervollständigen, seien beispielsweise auch Arm-Systeme mit AMD-GPUs im Zulauf - eine Kombination, die so sonst noch nirgends im Einsatz sei. „Wir portieren auch unseren eigenen Cluster-Software-Stack auf die Arm-Architektur, damit die Unterschiede in puncto Software möglichst klein ausfallen.“

Im Idealfall sollen die Nutzenden gar nicht bemerken, dass sie eine andere Hardware-Architektur benutzen, und sich auf die Portierung und Vermessung ihrer Anwendungen konzentrieren können. Bis dahin sei es aber oft ein weiter Weg. „Wir können derzeit beispielsweise nur über Umwege auf eines der großen parallelen Dateisysteme zugreifen, weil der Hersteller noch keine Version für Arm-Systeme anbietet. Hier arbeiten wir gemeinsam an einer Lösung.“ Das Ergebnis käme dann auch anderen Betreibern zu Gute, die erst später auf solche neuartigen Architekturen umsteigen. Die neuen Systeme werden derzeit in Zusammenarbeit mit NVIDIA mit passender Software versehen und stehen den Nutzenden voraussichtlich in wenigen Wochen zur Verfügung.

Weitere Informationen zur Future Technologies Partition, zu HoreKa und dem Nationalen Hochleistungsrechenzentrum NHR@KIT finden Sie unter www.nhr.kit.edu/

Kontakt am SCC: Simon Raffeiner

Achim Grindler

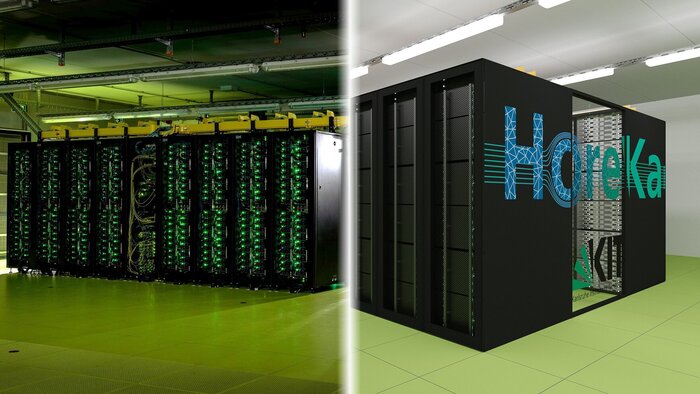

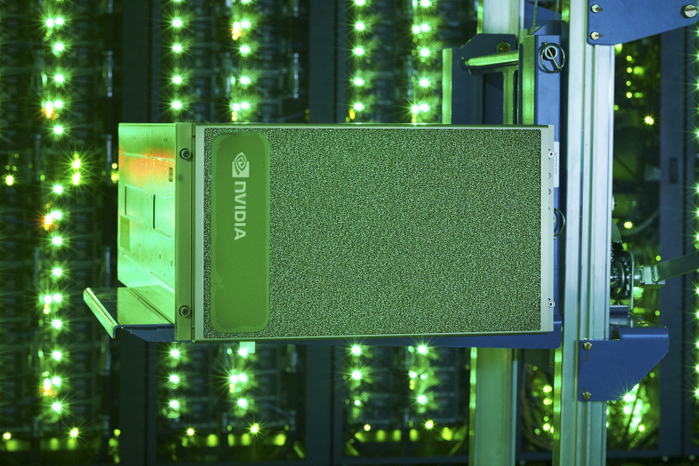

Dem Karlsruher dpa-Fotograf Uli Deck gelang es besonders gut die LED-Beleuchtung des neuen Supercomputers HoreKa am KIT in Szene zu setzen. Das Foto erhält beim Wettbewerb „dpa-Bilder des Jahres 2021“ einen 1. Platz.

Ein Besuch im Rechnerraum des im Juli 2021 offiziell eingeweihten Superrechners HoreKa (Hochleistungsrechner Karlsruhe) macht auf Fotografiebegeisterte großen Eindruck. Die Deckenbeleuchtung im Raum bleibt bei seinem Betreten für Besuchende erst einmal aus. Die Dunkelheit, der Lärm der Rechenmaschine, die Wärme und der Geruch im Raum stellt alle Sinne auf Empfang. Langsam gewöhnen sich die Augen an das Dämmerlicht. Rechenpower kann man ja nicht sehen, umsomehr beeindruckt aber das flackernde Lichterspiel von Abertausenden Leuchtdioden in grün und blau an der Rückseite des Rechenclusters, das man schon von der Eingangstür her sehen kann. Das Innenleben des Rechners ist über einen sogenannten Kaltgang zugänglich. Ihn zu betreten ist an jedem Besuch des SCC am Campus Nord des KIT ein Highlight.

Nicht nur die Technik begeistert, sondern auch das effektvolle Lichtspiel mit dem sie beleuchtet ist. Mit einer Fernbedienung steuert man elegant die Lichtquellen in den verschiedenen Bereichen des Innenraums von HoreKa. Farbe und Lichtstärke für die Beleuchtung des Superrechners können so angepasst werden, dass immer wieder anders aussehende Fotos möglich sind. Technik kann ja so fotogen sein! Wäre es nicht so kalt und laut dort, könnte dieser ungewöhnliche Ort zum Verweilen einladen und inspirierende Ideen und Gedanken fördern.

Besonders eindrucksvoll ist das so entstandene „Spiegelbild“ des Hochleistungsrechners, das der Karlsruher dpa-Fotograf Uli Deck bei der Einweihungsfeier von HoreKa eingefangen hat. Er hat mit dem Bild beim vielbeachteten Wettbewerb „dpa-Bild des Jahres“ den 1. Preis in der Kategorie Symbolbild gewonnen. Das SCC freut sich mit ihm. Herzlichen Glückwunsch!

Zur Pressemitteilung: dpa: dpa-Bilder des Jahres

Achim Grindler

Sieben Projekte erfolgreich im zweiten NHR@KIT Call for Collaboration

Das Nationalen Hochleistungsrechenzentrum des KIT (NHR@KIT) hat die Evaluation des zweiten NHR@KIT Call for Collaboration beendet. Im Rahmen dieser Ausschreibung waren Forschende aus den Feldern Erdsystemwissenschaft, Materialwissenschaften, Ingenieurwissenschaften im Bereich Energie und Mobilität sowie Teilchen- und Astroteilchenphysik und weiteren Disziplinen aufgerufen Vorschläge für kollaborative Forschungsprojekte einzureichen, die die Expertise von Wissenschaftlerinnen und Wissenschaftlern aus deren Domänen und dem High Performance Computing (HPC) verbindet. In einer kompetitiven, externen Begutachtung der Projekte waren sieben Projekte erfolgreich, die für bis zu drei Jahre gefördert werden.

Die erfolgreichen Anträge decken die gesamte Breite der wissenschaftlichen Domänen am Zentrum NHR@KIT ab und werden in enger Kollaboration mit entweder den Simulation and Data Life Cycle Labs (SDLs) oder dem Software Sustainability and Performance Engineering Team (SSPE) durchgeführt. Wir gratulieren den erfolgreichen Projekten und freuen uns auf den Start der kollaborativen Projekte.

Kontakt am SCC: René Caspart

Mit der vom SCC entwickelten Software oidc-agent stehen OpenID-Connect-Tools auf der Kommandozeile unter Debian Linux zur Verfügung.

Seit dem 2.1.2022 ist die SCC-Software „oidc-agent“ teil der Linux Distribution DEBIAN. Aktuell noch im Teil der neu aufgenommenen Software, dem so genannten unstable branch, lässt sich die SCC-Entwicklung nun einfach auf DEBIAN Linux installieren.

oidc-agent beinhaltet eine Reihe von Werkzeugen zur Verwaltung von OpenID-Connect-Tokens und macht sie leicht von der Kommandozeile aus nutzbar. Dabei wurde sich an das Design von ssh-agent angelehnt, so dass Nutzende mit OIDC-Tokens auf ähnliche Weise umgehen können wie mit ssh-Schlüsseln. oidc-agent wird zu Beginn einer X-Sitzung oder einer Login-Sitzung gestartet. Durch die Verwendung von Umgebungsvariablen kann der Agent gefunden und zur Verwaltung von OIDC-Tokens verwendet werden.

Die Software steht über einen Repository Server am SCC auch für eine Reihe weiterer Linux Distributionen bereit.

Weitere Informationen finden sich auf der Homepage von oidc-agent und im GitBook.

Ansprechpartner für oidc-agent: Gabriel Zachmann.

Dr. Marcus Hardt

Als erster Betreiber in Deutschland bietet das Nationale Hochleistungsrechenzentrum NHR@KIT Forschenden Zugang zu einem KI-System vom Typ IPU-POD16.

Algorithmen und Verfahren aus den Bereichen der Künstlichen Intelligenz und des Maschinellen Lernens (KI/ML) nehmen im modernen Wissenschaftsbetrieb eine zunehmend wichtigere Rolle ein. In der praktischen Anwendung wird ein sehr hohes Maß an Rechenleistung benötigt. Da die Leistung herkömmlicher Standardprozessoren meist nicht ausreicht, setzen Forschende und Betreiber wissenschaftlicher Rechenzentren häufig auf spezielle Beschleunigerprozessoren, welche die benötigten Rechenoperationen wie z.B. Matrixmultiplikationen sehr schnell ausführen können.

Bislang handelte es sich dabei fast ausschließlich um enge Verwandte jener Grafikprozessoren, welche auch in herkömmlichen PCs oder Spielekonsolen Verwendung finden. Deren interner Aufbau eignet sich zwar auch zur Beschleunigung wissenschaftlicher Anwendungen oder von Berechnungen im Bereich KI/ML, in Rechenzentren werden allerdings leistungsfähigere Modelle mit für den professionellen Einsatz nötigen Zusatzfunktionen benötigt. Das Scientific Computing Center (SCC) betreibt derzeit insgesamt mehr als 1.000 dieser Beschleunigerprozessoren, darunter fast 700 im neuen Hochleistungsrechner Karlsruhe (HoreKa) und mehr als 130 im bwUniCluster 2.0.

Die derzeit verwendeten Beschleuniger der Hersteller NVIDIA (Typen A100 und V100) und AMD (Typ MI100) erreichen eine etwa um den Faktor 10 höhere Rechenleistung und Energieeffizienz als herkömmliche Standardprozessoren. HoreKa schaffte es dank seiner A100-Beschleuniger auf Platz 13 auf der Liste der energieeffizientesten Rechner der Welt (Stand Juni 2021). Allerdings besteht im Bereich KI/ML noch ein großes Optimierungspotential.

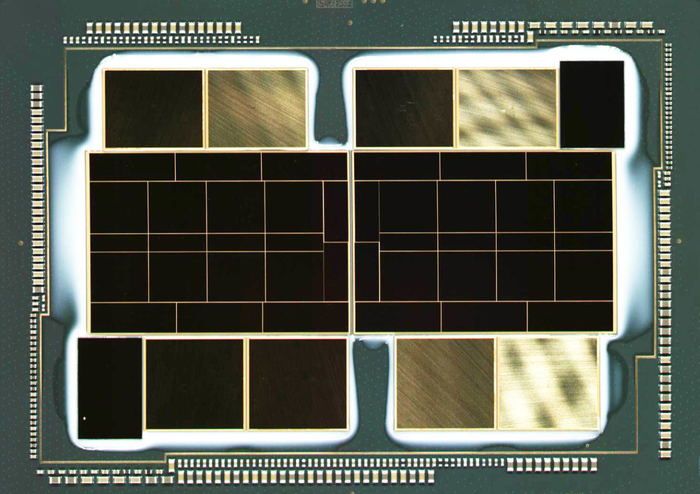

Das 2016 gegründete Startup Graphcore aus Großbritannien arbeitet als eines von mehreren Unternehmen an entsprechenden Produkten. Graphcore bezeichnet seine Prozessoren als „Intelligent Processing Units“ (IPUs). Das aktuelle Modell GC200 gehört mit 59 Milliarden Transistoren zu den größten weltweit gefertigten Chips und trägt daher den Beinamen „Colossus“.

Im Gegensatz zu den Chips von NVIDIA und AMD, die die ganze Palette wissenschaftlicher Anwendungen unterstützen, beherrschen „Colossus“-Prozessoren vor allem die für KI/ML wichtigen Rechenoperationen mit Datentypen reduzierter Genauigkeit. Bis zu 250 Billionen dieser speziellen Rechenoperationen pro Sekunde (AI Floating Point Operations, AI-FLOPS) kann ein einzelner Chip ausführen. Das nun vom Nationalen Hochleistungsrechenzentrum NHR@KIT als Teil der sogenannten „Future Technologies Partition“ angebotene IPU-POD16 System verfügt über gleich 16 Colossus-Prozessoren. Es ist das erste System dieser Art in Deutschland.

Forschende mit Zugang zu HoreKa oder aus dem Verbund für das Nationale Hochleistungsrechnen (NHR-Verbund) erhalten auf Anfrage Zugang zur Future Technologies Partition. In diesem Hardware- und Software-Testbett für innovative und disruptive Technologien stehen neben den neuen Graphcore-Systemen auch Systeme mit AMD-Prozessoren, AMD-Beschleunigern, ARM-Prozessoren und anderer Ausstattung zur Verfügung.

Weitere Informationen zu den neuen Systemen sind in der Nutzerdokumentation von NHR@KIT abrufbar. Informationen zum Nationalen Hochleistungsrechnen am KIT finden sich auf der Webseite von NHR@KIT.

Simon Raffeiner

Forschende und Mitglieder der Helmholtz AI aus dem SCC und dem Jülich Supercomputing Center haben gemeinsam ihre Ergebnisse aus einer Wettbewerbsinitiative mit der HPC benchmarking-Software MLPerf™ zur Supercomputing-Konferenz 21 eingereicht.

Helmholtz AI ist eine Kooperationsplattform, in der KI-Teams aus Deutschlands größten Forschungseinrichtungen zusammenarbeiten, um Wissenschaftlerinnen und Wissenschaftler anderer Fachrichtungen mit modernsten KI-Methoden zu unterstützen. Vor diesem Hintergrund haben Forschende und Mitglieder der Helmholtz AI aus dem SCC und dem JSC gemeinsam ihre Ergebnisse aus einer Wettbewerbsinitiative mit der HPC benchmarking-Software MLPerf™ zur Supercomputing-Konferenz 21 (SC21) eingereicht. Diese Initiative wurde 2020 von IT- und Softwarefirmen wie Baidu, Google und GraphCore sowie von Forschenden der Universitäten Stanford, Harvard und Berkeley ins Leben gerufen, um groß-skalige KI-Anwendungen intensiv zu untersuchen. Das KI-Team aus Jülicher und Karlsruher Forschenden entschied sich die Anwendung DeepCAM für KI-unterstützte Videolösungen und die Anwendung CosmoFlow, beide Deep-Learning-Anwendungen für neuronale Netzen zu untersuchen. Das Helmholtz AI-Team des SCC trainierte DeepCAM auf dem KIT-Supercomputer HoreKa unter Nutzung von 512 NVIDIA A100 GPUs und CosmoFlow zusätzlich auf dem Jülicher Superrechner JUWELS Booster.

DeepCAM, eine mit dem Gordon-Bell Preis 2019 ausgezeichnete Deep Learning KI-Software, ermöglicht es, Zyklone aus Klimaforschungsdaten zu erkennen. Das frühzeitige Aufspüren tropischer Wirbelstürme, die sich über dem Indischen und Südpazifischen Ozean bilden, ist entscheidend, um Menschenleben und Infrastruktur effektiv zu schützen sowie landwirtschaftlich nutzbare Trockengebiete zu bestimmen. Mit HoreKa konnte Daniel Coquelin im Team um Markus Götz die von DeepCAM geforderten mehr als 100 Billiarden Berechnungen in nur 4 Minuten und 21 Sekunden ausführen.

Bei allem Streben nach höherer Rechenleistung, ist es auch wichtig den klimaschädlichen Energieverbrauch solcher groß angelegter Messungen abzuwägen. Mit HoreKa und JUWELS, die auf der weltweiten Green500-Liste energieeffizienter Supercomputer unter den Top 15 rangieren, sind die Helmholtz AI-Rechenressourcen sowohl rechen- als auch sehr energieeffizient, was sie zu Europas schnellsten und umweltfreundlichsten Systemen für äußerst rechenintensive KI-Aufgaben macht. Die durchgeführten Benchmarks haben nicht nur geholfen, die aktuellen Systeme besser zu verstehen, sondern auch Wege für Verbesserungen zukünftiger Systeme aufgezeigt, denn die zur Verfügung gestellten Testwerkzeuge zeigen Administrierenden und Nutzenden gleichermaßen den CO2-Fußabdruck jedes einzelnen Rechenjobs auf.

Das KI-Team der Helmholtz-Plattform hofft auch im nächsten Jahr wieder Teil dieses herausfordernden und spannenden Wettbewerbs zu sein. Dabei wollen die HPC-Spezialistinnen und -Spezialisten nicht nur die im geschlossenen Modus des Wettbewerbs bestehenden, offiziellen Anwendungen im Ist-Zustand messen, sondern auch am sogenannten offenen Modus teilnehmen und dort einige fortgeschrittene, groß angelegte Trainingskonzepte präsentieren.

Weitere Informationen:

www.fz-juelich.de/SharedDocs/Meldungen/PORTAL/DE/2021/2021-11-18-mlperf-hpc.html

blogs.nvidia.com/blog/2021/11/17/mlperf-hpc-ai/

https://developer.nvidia.com/blog/mlperf-hpc-v1-0-deep-dive-into-optimizations-leading-to-record-setting-nvidia-performance/

Kontakt am SCC: Markus Götz

Achim Grindler

Möglichkeit für kollaborative Projekte im Rahmen von NHR@KIT

Zum zweiten Mal gibt es im Rahmen des Nationalen Hochleistungsrechnen (NHR) am KIT die Möglichkeit für kollaborative wissenschaftliche Projekte. Dabei können Forschungstätigkeiten von Promovierenden sowie Postdoktorandinnen und Postdoktoranden in kollaborativen Forschungsprojekten finanziert werden. In diesen Projekten arbeiten Wissenschaftlerinnen und Wissenschaftler aus dem NHR@KIT und aus den Bereichen Erdsystemwissenschaft, Materialwissenschaften, Ingenieurwissenschaften im Bereich Energie und Mobilität sowie Teilchen- und Astroteilchenphysik zusammen. Wir öffnen eine Ausschreibung für Projektvorschläge von Forschenden aus diesen Bereichen.

Weitere Informationen sowie die Ausschreibung (auf Englisch) finden Sie unter nhr.kit.edu/collaboration-call

Kontakt: René Caspart

Der Verbund für das Nationale Hochleistungsrechnen (NHR-Verbund) hat eine eigene Graduiertenschule gegründet. Auch das NHR-Zentrum am KIT, NHR@KIT, beteiligt sich.

Der NHR-Verbund organisiert seit dem 1. Januar 2021 das Hochleistungsrechnen auf nationaler Ebene. Die neun NHR-Zentren, darunter das NHR-Zentrum am KIT, NHR@KIT, koordinieren gemeinsam die Ressourcen und Dienstleistungen, die Forschenden aus ganz Deutschland angeboten werden. Um junge Wissenschaftlerinnen und Wissenschaftler im Hochleistungsrechnen angemessen auszubilden und deren Vernetzung zu fördern, wurde nun eine eigene Graduiertenschule gegründet.

Das Angebot richtet sich an Absolventen eines Masterstudiengangs aus den Bereichen der Computerwissenschaften, der Mathematik, der Naturwissenschaften oder der Ingenieurwissenschaften, die eine Promotion in einem der von den NHR-Zentren abgedeckten Forschungsgebiete anstreben. Am KIT gehören dazu beispielsweise effiziente numerische Methoden für die Exascale-Systeme, die nachhaltige Softwareentwicklung von wissenschaftlichen Anwendungen oder das datenintensive Rechnen.

Mitglieder der Graduiertenschule werden in ein reguläres Promotionsprogramm am Standort eines der NHR-Zentren aufgenommen, sollen aber auch für mindestens sechs Monate an einem anderen NHR-Zentrum tätig sein. Zudem bietet die NHR-Graduiertenschule ein eigenes Curriculum in für das HPC besonders relevanten Bereichen, individuelle Betreuung (Mentoring) und Kurse zur Vermittlung von "Soft Skills" an.

Bis zu neun Bewerberinnen und Bewerber pro Jahr werden akzeptiert, die zusätzlich ein Stipendium für 36 Monate erhalten. Die Bewerbung für das Graduiertenprogramm 2022 läuft noch bis zum 15. Dezember 2021 und steht auch Interessierten außerhalb der Europäischen Union offen.

Weitere Informationen: www.nhr-gs.de/ueber-uns/nhr-graduiertenschule.

Kontakt am SCC: Martin Frank

Achim Grindler

Der Hochleistungsrechner Karlsruhe HoreKa zählt zu den schnellsten Rechnern in Europa. Auf der TOP500-Liste belegt das HPC-System Rang 52. Bei der Energieeffizienz liegt es im internationalen Ranking auf einem hervorragenden 13. Platz.

Zum 1. Juni nahm das KIT als Nationales Hochleistungsrechenzentrum (NHR@KIT) den wissenschaftlichen Betrieb des neuen Hochleistungsrechners „HoreKa“ auf. In der aktuellen Top-500-Frühjahrsliste zählt das System zu den fünfzehn schnellsten Rechnern in Europa; im weltweiten Vergleich belegt es Rang 52. In Bezug auf die Energieeffizienz erreicht HoreKa im internationalen Ranking den 13. Platz.

Das Hybridsystem bestehend aus einem auf Grafikprozessoren (GPUs) basierenden Rechenbeschleuniger und einer mit Standardprozessoren (CPUs) ausgestatteten Partition. Durch die GPUs der Firma NVIDIA wird eine extrem hohe Leistung garantiert, die etwa für bestimmte Rechenoperationen wie Gleichungssystemlöser oder Algorithmen für Anwendungen in der Künstlichen Intelligenz benötigt wird. Die neuste Generation der Intel-CPUs, die mit Beginn des HoreKa-Testbetriebs erst offiziell vorgestellt wurden, sind ebenfalls für bestimmte Operationen optimiert. HoreKa kombiniert die Stärken beider Architekturen geschickt, sodass ein Maximum an Leistungsfähigkeit erreicht wird. Insgesamt erreicht das System eine Spitzenleistung von 17 PetaFlop/s. Das ThinkSystem von Lenovo wurde durch die pro-com Datensysteme GmbH geliefert.

Kontakt: Dr. Jennifer Buchmüller

Weitere Informationen: kit.edu/kit/pi_2021_059_supercomputer-des-kit-einer-der-15-schnellsten-in-europa.php

Achim Grindler

Nach erfolgreichem Abschluss des Pilotbetriebs nimmt das Nationale Hochleistungsrechenzentrum (NHR-Zentrum) des KIT pünktlich zum 1. Juni 2021 den wissenschaftlichen Betrieb des neuen Supercomputers HoreKa auf.

Ab sofort steht der Supercomputer "HoreKa" allen Wissenschaftlerinnen und Wissenschaftlern aus ganz Deutschland für Forschungsprojekte zur Verfügung. Der Pilotbetrieb konnte erfolgreich abgeschlossen und das System heute in den wissenschaftlichen Betrieb übernommen werden.

Vor allem in den Materialwissenschaften, den Erdsystemwissenschaften, der Energie- und Mobilitätsforschung im Ingenieurwesen sowie der Teilchen- und Astroteilchenphysik können Forschende dank des neuen Supercomputers ein detaillierteres Verständnis hochkomplexer natürlicher und technischer Vorgänge erlangen.

Innovatives Hochleistungssystem mit großem Datenhunger

HoreKa ist ein innovatives Hybrid-System mit fast 60.000 Intel Prozessorkernen, mehr als 220 Terabyte Hauptspeicher sowie 668 NVDIA A100 GPUs. Als Kommunikationsnetzwerk kommt ein non-blocking InfiniBand-HDR-Netzwerk mit 200 GBit/s zum Einsatz, als Datenablage dienen zwei parallele Spectrum-Scale-Dateisysteme mit einer Gesamtkapazität von mehr als 15 Petabyte.

Ein zentraler Gesichtspunkt bei der Auslegung des Systems waren auch die enormen Datenmengen, welche bei wissenschaftlichen Forschungsprojekten anfallen. Um mit den wachsenden Datenmengen Schritt zu halten, liefern die Rechenknoten, das InfiniBand-Netzwerk und die parallelen Dateisysteme von HoreKa im Vergleich zum Vorgängersystem ForHLR jeweils einen bis zu vier Mal höheren Speicherdurchsatz. Eine mehrstufige Datenhaltung soll zusätzlich die Weiterverarbeitung auf externen Speichersystemen mit hohem Durchsatz garantieren.

HoreKa ist vollständig im 2015 für den Vorgänger ForHLR neu errichteten Rechnergebäude auf dem Campus Nord des KIT untergebracht. Das preisgekrönte, energieeffiziente Heißwasser-Kühlkonzept wird mit dem neuen System fortgeführt.

Rechenzeit kann ab sofort beantragt werden

Die Antragsstellung für Rechenzeitprojekte auf HoreKa ist ab sofort über die digitale Antragsplattform möglich. Zusätzlich steht mit dem neuen NHR Support-Portal eine integrierte Plattform für alle Fragen rund um Antragstellung sowie technische und fachliche Unterstützung zur Verfügung. Organisatorische Fragen zu HoreKa können auch an horeka-info@nhr.kit.edu gestellt werden.

Die offizielle Einweihungsfeier von HoreKa findet Mitte Juli statt. Eine Einladung folgt.

_ _ _

Mehr Informationen zu HoreKa:

https://www.nhr.kit.edu/userdocs/horeka/

Mit dem bwUniCluster 2.0 betreibt das KIT einen zweiten Supercomputer im Landesdienst:

https://www.scc.kit.edu/dienste/bwUniCluster_2.0.php

Dr. Jennifer Buchmüller

Möglichkeit für kollaborative Projekte im Rahmen von NHR@KIT

Im Rahmen des Nationalen Hochleistungsrechnen (NHR) am KIT können Forschungstätigkeiten von Promovierenden, Postdoktorandinnen und Postdoktoranden in kollaborativen Forschungsprojekten finanziert werden. In diesen Projekten arbeiten Wissenschaftlerinnen und Wissenschaftler aus dem NHR@KIT und aus den Bereichen Erdsystemwissenschaft, Materialwissenschaften, Ingenieurwissenschaften im Bereich Energie und Mobilität sowie Teilchen- und Astroteilchenphysik zusammen. Wir öffnen eine Ausschreibung für Projektvorschläge von Forschenden aus diesen Bereichen.

Weitere Informationen sowie die Ausschreibung (auf Englisch) finden Sie unter nhr.kit.edu/collaboration-call

Kontakt: René Caspart

Mit dem Start des Pilotbetriebs von HoreKa beginnt auch die Abschaltung des Forschungshochleistungsrechners II

Karlsruhe - Das SCC hat den Pilotbetrieb des neuen Supercomputers „Hochleistungsrechner Karlsruhe“ - kurz HoreKa – aufgenommen. Während HoreKa in den nächsten Wochen auf seine volle Leistungsfähigkeit hochgefahren wird, beginnt damit nach fünfjährigem erfolgreichen Betrieb auch die Abschaltung des Vorgängers ForHLR II.

Bei seiner Inbetriebnahme im März 2016 gehörte der Forschungshochleistungsrechner II (ForHLR II) des KIT zu den wenigen Rechnern weltweit, die eine Rechenleistung von mehr als einem PetaFLOPS - also einer Billiarde Rechenoperationen pro Sekunde – erreichen konnten. Dafür waren damals mehr als 1150 Rechenknoten mit insgesamt fast 24.000 CPU-Kernen und 74 Terabyte Hauptspeicher nötig.

Aber nicht nur in Punkto Rechenleistung, sondern auch in einem anderen Bereich spielte das KIT mit dem ForHLR II ganz vorne mit: Das System wurde nicht mit kaltem, sondern mit bis zu 45 Grad heißem Wasser gekühlt. Damals nicht nur ein Novum in diesem Bereich, sondern auch der Grund für den Neubau eines Rechenzentrums für den Supercomputer am Campus Nord des KIT. Für das energieeffiziente Gesamtkonzept wurde dem SCC 2017 der Deutsche Rechenzentrumspreis verliehen.

Drei Jahre Vorarbeit für HoreKa

Die konkreten Planungen für ein Nachfolgesystem begannen bereits 2018. Im Jahr 2019 wurde das Projekt auf den Namen „Hochleistungsrechner Karlsruhe“ - kurz HoreKa - getauft und mit der Beschaffung begonnen. HoreKa wird allerdings nicht nur ein würdiger Nachfolger für den ForHLR II sein. Mit 769 Rechenknoten, fast 60.000 CPU-Kernen, mehr als 220 Terabyte Hauptspeicher und 668 GPUs wird das System eine theoretische Spitzenleistung von mehr als 17 PetaFLOPS erreichen und damit 17-mal so schnell sein wie der Vorgänger. Mitte 2021 soll HoreKa damit voraussichtlich zu den zehn schnellsten Rechnern Europas gehören.

Vor allem in den Materialwissenschaften, den Erdsystemwissenschaften, der Energie- und Mobilitätsforschung, im Ingenieurwesen sowie der Teilchen- und Astroteilchenphysik werden Forschende dank des neuen Supercomputers ein detaillierteres Verständnis hochkomplexer natürlicher und technischer Vorgänge erlangen können. Selbstverständlich kann HoreKa bei Bedarf auch von Wissenschaftlerinnen und Wissenschaftlern genutzt werden, die zum Verständnis des Virus SARS-CoV-2 forschen und damit zur Bekämpfung der Krankheit COVID-19 beitragen.

Rechnen und Speichern gehen Hand in Hand

Ein zentraler Gesichtspunkt bei der Auslegung des Systems waren auch die enormen Datenmengen, welche bei wissenschaftlichen Forschungsprojekten anfallen. Je nach Anwendung können von einer einzigen Simulation mehrere Hundert Terabyte erzeugt werden. Um mit den wachsenden Datenmengen Schritt zu halten, liefern die Rechenknoten, das InfiniBand-Netzwerk und die parallelen Dateisysteme von HoreKa im Vergleich zum Vorgängersystem ForHLR jeweils einen bis zu viermal höheren Durchsatz.

Eine mehrstufige Datenhaltung soll zusätzlich die schnelle Weiterverarbeitung auf externen Speichersystemen garantieren. HoreKa ist mit bis zu 45 GByte/s Datenrate an die „Large Scale Data Facility“ (LSDF) des SCC angebunden, die seit 2010 eine moderne Infrastruktur für die Speicherung, Verwaltung, Archivierung und Analyse von Forschungsdaten bietet.

Vollbetrieb von HoreKa beginnt zum 1. Juni

HoreKa wurde in den letzten Monaten direkt neben dem ForHLR II aufgebaut und in Betrieb genommen. Erste Nutzergruppen haben bereits Zugriff erhalten, um ihre Anwendungen anpassen und optimieren zu können. In den nächsten Wochen wird das System auf seine volle Leistungsfähigkeit hochgefahren und der Pilotbetrieb nahtlos in einen Vollbetrieb übergehen. Ab dem 1. Juni 2021 soll HoreKa dann Wissenschaftlerinnen und Wissenschaftlern aus ganz Deutschland zur Verfügung stehen. Anträge auf Rechenzeit können bereits jetzt gestellt werden.

Da das Rechenzentrum am Campus Nord nicht beide Systeme gleichzeitig versorgen kann, muss der ForHLR II parallel stufenweise zurückgebaut werden. Bis Mitte April wird das System dann vollständig abgeschaltet sein und nicht mehr zur Verfügung stehen. Die Bilanz des fünfjährigen Betriebs fällt äußerst positiv aus: Mehr als 140 verschiedenen Forschungsprojekten konnte insgesamt fast eine Milliarde CPU-Stunden Rechenzeit zur Verfügung gestellt werden.

Mehr Informationen zu HoreKa und zur Antragsstellung für das neue System: www.nhr.kit.edu/userdocs/horeka/

Mehr Information zu COVID-19-Forschung am KIT:

www.kit.edu/kit/corona-pandemie-forschung-und-hilfsaktivitaeten-am-kit.php

www.scc.kit.edu/ueberuns/13531.php

Mit dem bwUniCluster 2.0 betreibt das KIT einen zweiten Supercomputer im Landesdienst: www.scc.kit.edu/dienste/bwUniCluster_2.0.php

Jennifer Buchmüller

Simon Raffeiner

Hartwig Anzt, Leiter der Helmholtz-Nachwuchsgruppe FiNE, stellt erste Erfahrungen in der Softwareportierung für Intel GPUs vor.

Im auf HPCwire veröffentlichten Artikel „Preparing for the Arrival of Intel’s Discrete High-Performance GPUs“ präsentiert Hartwig Anzt, Leiter der Helmholtz-Nachwuchsgruppe FiNE, erste Erfahrungen in der Softwareportierung für Intel GPUs.

Das Team um Hartwig Anzt gehört zu den ersten weltweit, die Software für die zu erwartenden diskreten Intel GPUs entwickelt. In enger Zusammenarbeit mit Intel und dem Argonne National Lab, das den ersten auf Intel GPUs basierenden Exascale Supercomputer plant, hat das Forschungsteam in der Programmiersprache DPC++ein Backend für die Open-Source-Softwarebibliothek Ginkgo entwickelt, das bereits jetzt numerische Verfahren komplett auf Intel GPUs ausführen kann.

Der HPCwire-Artikel diskutiert einen Workflow, um CUDA-Code in DPC++-Code umzuwandeln und die damit einhergehenden Herausforderungen. Auch wenn Intels GPUs und das oneAPI-Ökosystem noch mit diversen Kinderkrankheiten kämpft, könnte es die von Intel gewählte Open-Source-Strategie schaffen die wissenschaftliche Community mitzunehmen.

Millionenförderung für künftige Supercomputer am SCC des KIT – Forschende in ganz Deutschland können enorme Karlsruher Rechenleistung nutzen.

Das Karlsruher Institut für Technologie (KIT) wird Zentrum für Nationales Hochleistungsrechnen (NHR). Das hat die Gemeinsame Wissenschaftskonferenz heute (13.11.2020) beschlossen – das Gremium koordiniert die Wissenschaftsförderung von Bund und Ländern. Somit werden Wissenschaftlerinnen und Wissenschaftler zukünftig noch gewaltigere Hochleistungsrechner am KIT nutzen können. Mit HoreKa wird am Scientific Computing Center des KIT im Frühjahr 2021 einer der leistungsstärksten Supercomputer Europas stehen. Die NHR-Allianz hat ein Jahresbudget von 62,5 Millionen Euro, ein hoher einstelliger Millionenbetrag geht jährlich ans KIT.

Presseinformation des KIT: pi_2020_101_kit-wird-zentrum-fur-nationales-hochleistungsrechnen.php

Presseinformation der GWK: pm2020-11.pdf

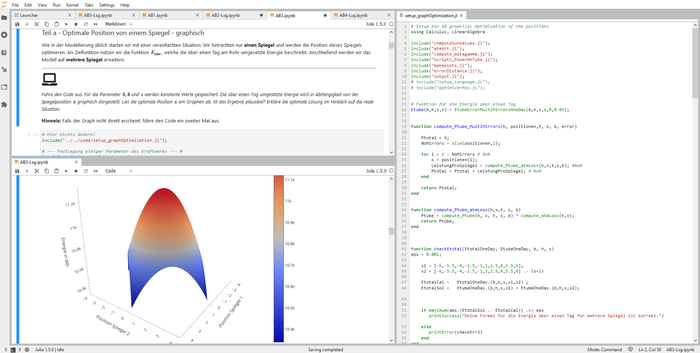

Mit JupyterLab können Forschende des KIT nun sehr einfach mit einem Webbrowser von jedem Arbeitsplatzrechner aus direkt mit den Hochleistungsrechnern des SCC interagieren. Damit bieten sich auch neue Möglichkeiten für Lehrveranstaltungen.

Das Projekt Jupyter [1] begann vor einigen Jahren. Es entwickelte sich zu einem Projekt, das heute ein vollständiges Open-Source-Ökosystem für Programmierung, Datenexploration und Codeausführung darstellt. Am wichtigsten ist jedoch, dass Jupyter eine neue Art des Supercomputings bietet, die ein interaktives Arbeiten mit Kernels, Texteditoren und Datenvisualisierungen auf HPC-Systemen ermöglicht.

Seit Ende Oktober bietet das SCC Jupyter als Service an [2]. Neben dem klassischen Zugang via SSH, ist nun auch der Zugriff via Webbrowser auf alle HPC-Systeme des SCC interaktiv möglich. Für das Tier-3 System, bwUniCluster2.0 + GFB-HPC, die neuen KI/ML-GPUs der HAICORE-Partition und das Tier-2 Bestandssystem ForHLR II sind dedizierte Warteschlangen für Jupyter reserviert.

Dies minimiert Wartezeiten und ermöglicht gerade neuen Nutzerinnen und Nutzern unserer HPC-Systeme eine niedrige Einstiegsschwelle.

Zur Nutzung von Jupyter auf den HPC-Ressourcen des SCC gelten die jeweiligen Zugriffsvoraussetzungen. Die Registrierung der Zugangs über bwidm.scc.kit.edu/ wird vorausgesetzt. Der Jupyter-Service ist nur innerhalb des KIT-Netzes erreichbar. Soll der Dienst von außerhalb verwendet werden, muss zunächst eine VPN-Verbindung ins KIT-Netz hergestellt werden.

Referenzen:

[1] Eine ausführliche Dokumentation des Jupyter Projekts findet sich unter jupyter.readthedocs.io.

[2] Weitere Informationen zum Jupyter-Service in der Servicebeschreibung

Kontakt am SCC: Jennifer Buchmüller, Samuel Braun

Achim Grindler

Wegen eines IT-Sicherheitsvorfalls mussten Mitte Mai auch die HPC-Systeme des KIT außer Betrieb genommen werden. Mit der Einführung einer 2-Faktor-Authentifizierung stehen die Systeme nun wieder uneingeschränkt zur Verfügung.

Mitte Mai ist ein IT-Sicherheitsvorfall bekannt geworden, der eine Vielzahl von HPC-Systemen weltweit betraf. Erst nach einigen Wochen konnten die Systeme den Nutzern erneut zur Verfügung gestellt werden, oft mit deutlichen Einschränkungen. Die beiden Hochleistungsrechner bwUniCluster 2.0 (Tier-3) und ForHLR II (Tier-2) am KIT wurden Mitte Juni wieder für den Nutzerbetrieb freigegeben. In der föderativ abgestimmten ersten von insgesamt drei Phasen der Wiederinbetriebnahme war u.a. die Verwendung von SSH-Keys unterbunden. Dies bedeutete insbesondere für das Tier-2-System eine massive Einschränkung des wissenschaftlichen Betriebs, da die HPC-Systeme nicht mehr automatisiert in wissenschaftliche Workflows eingebunden werden konnten.

Innerhalb von wenigen Wochen ist es dem SCC nun gelungen, eine 2-Faktor-Authentifizierung (2FA) für alle HPC-Systeme mit zeitbasierten Einmalpasswörtern (TOTP) einzuführen. Für die Generierung der Einmalpasswörter können sogenannte Hardware- oder Software-Tokens verwendet werden. Beschäftigte des KIT erhalten im Rahmen ihres Dienstverhältnisses ein Hardware-Token für den Zugriff auf kritische Dienste wie das SAP-Portal oder das Campus-Management (www.scc.kit.edu/dienste/2fa.php). Diese können auch für den Zugriff auf die HPC-Systeme genutzt werden. Nutzern anderer Standorte steht ein breites Angebot an Lösungen für Software-Tokens zur Verfügung, darunter Apps für Mobilgeräte. Die Registrierung und Verwaltung der Token erfolgt über das Portal des föderativen Identitätsmanagementsystems bwIDM.

In Kombination mit der 2FA ist auch die Nutzung von SSH-Keys wieder möglich. Diese müssen ebenfalls über bwIDM verwaltet werden. Bei den SSH-Keys erfolgt eine Unterscheidung zwischen Schlüsseln für interaktive Nutzung und solchen für die Automatisierung von Workflows (sog. kommandobezogene Keys). Für eine interaktive Nutzung registrierte SSH-Keys erlauben die Ausführung beliebiger Kommandos und erfordern eine zusätzliche Authentifizierung mit einem zeitbasierten Einmalpasswort als zweitem Faktor. Die Eingabe des zweiten Faktors ist maximal ein Mal pro Stunde nötig. Kommandobezogene SSH-Keys sind ohne 2FA und damit automatisiert nutzbar. Allerdings müssen diese auf ein einzelnes Kommando eingeschränkt sein und vom HPC-Betriebsteam freigegeben werden.

Weitere Betreiber aus dem bwHPC-Verbund planen die Einführung der 2-Faktor-Authentifizierung auf Basis der für das bwIDM neu entwickelten Komponenten. Der Quellcode steht Interessierten unter einer Open-Source-Lizenz zur Verfügung.

Detaillierte Informationen zur 2-Faktor-Authentifizierung im HPC-Bereich finden sich in den Nutzerdokumentationen des ForHLR II und des bwUniCluster 2.0.

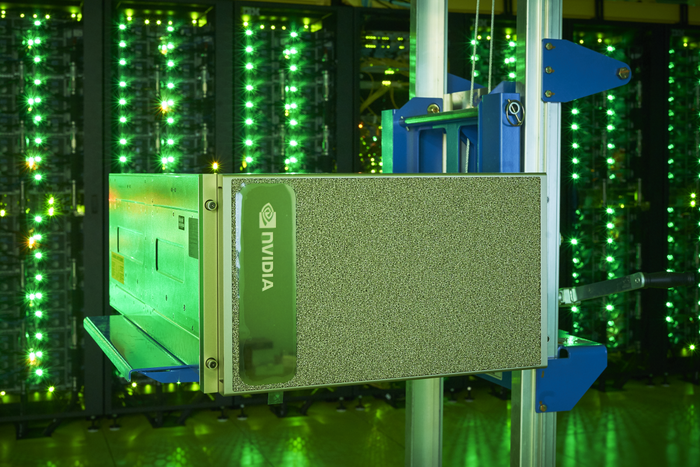

Damit Forschende der Helmholtz-Gemeinschaft auch weiterhin bei der Entwicklung von KI und Machine Learning ganz vorne mit dabei sind, hat das KIT nun als erster Standort in Europa modernste KI-Systeme vom Typ NVIDIA DGX A100 in Betrieb genommen.

Als ein Werkzeug der Spitzenforschung ist Künstliche Intelligenz (KI) heute unentbehrlich. Für einen erfolgreichen Einsatz – ob in der Energieforschung oder bei der Entwicklung neuer Materialien – wird dabei neben den Algorithmen zunehmend auch spezialisierte Hardware zu einem immer wichtigeren Faktor. Das Karlsruher Institut für Technologie (KIT) hat nun als erster Standort in Europa das neuartige KI-System NVIDIA DGX A100 in Betrieb genommen. Bei den neuen Computersystemen vom Typ DGX A100 handelt es sich um Hochleistungsserver mit jeweils acht NVIDIA A100 Tensor Core GPUs. Gemeinsam erbringen die acht Beschleuniger eine Rechenleistung von 5 AI-PetaFLOP/s. Angeschafft wurde es aus Mitteln der Helmholtz AI Computing Resources (HAICORE) Initiative, die eng mit Helmholtz AI verbunden ist.

Weitere Informationen in der Presseinformation des KIT vom 6.7.2020

Achim Grindler

Die Helmholtz-Nachwuchsgruppe Fixed-Point Methods for Numerics at Exascale wurde in das Konsortium des US-amerikanischen Exascale Computing Projekts aufgenommen und erhält bis 2022 Fördermittel von mehr als einer Million Euro.

Am 29.7.2015 hat der damalige Präsident der USA, Barack Obama, mit einer Executive Order die National Strategic Computing Initiative (NSCI) gestartet. Diese gesamtstaatliche Initiative zielt darauf ab, eine behördenübergreifende strategische Vision und eine föderale Investitionsstrategie zu entwickeln, die in Zusammenarbeit mit Industrie und Wissenschaft durchgeführt wird, um die Vorteile von High Performance Computing (HPC) für die USA zu maximieren.

Teil der NSCI ist das Exascale Computing Project (ECP) mit dem Ziel der beschleunigten Bereitstellung eines leistungsfähigen Exascale-Computersystems und der Entwicklung eines nachhaltigen Softwareökosystems für wissenschaftliche Simulationen. Aufgrund der vorhandenen Expertise in der Entwicklung numerischer Softwarebibliotheken und nachhaltiger Softwareentwicklung wurde die Helmholtz-Nachwuchsgruppe Fixed-Point Methods for Numerics at Exascale (FiNE) von Dr. Hartwig Anzt am Scientific Computing Center in das Konsortium aufgenommen und erhält bis 2022 Fördermittel von mehr als einer Million Euro.

Das Team um Hartwig Anzt (s. Foto) wird sich dabei speziell auf die Entwicklung numerischer Verfahren und produktionsfähiger Codes spezialisieren, die in niedriger Genauigkeit operieren und dennoch Ergebnisse mit hoher Genauigkeit erreichen. Diese sogenannten "Mixed Precision Algorithms" können die hohe Performanz moderner, AI-fokussierter Hardware nutzen und so effizient für numerische Verfahren und wissenschaftliche Simulationen eingesetzt werden.

Kontaktpersonen am SCC: Hartwig Anzt, Martin Frank

Weitere Informationen:

Multiprecision Effort (Exascale-Podcast mit Hartwig Anzt): insidehpc.com/2019/12/podcast-developing-multiprecision-algorithms-with-the-ginkgo-library-project/

Das SCC nimmt am 17.03.2020 im Rahmen des baden-württembergischen Umsetzungskonzepts für Hochleistungsrechnen (bwHPC) das neue Parallelrechnersystem „bwUniCluster 2.0+GFB-HPC“ (kurz bwUniCluster 2.0) als Landesdienst in Betrieb.

Das SCC nimmt am 17.03.2020 im Rahmen des baden-württembergischen Umsetzungskonzepts für Hochleistungsrechnen (bwHPC) das neue Parallelrechnersystem „bwUniCluster 2.0+GFB-HPC“ (kurz bwUniCluster 2.0) als Landesdienst in Betrieb. Der bwUniCluster 2.0 ersetzt das Vorgängersystem „bwUniCluster“ und umfasst auch die im November 2016 beschaffte Erweiterung des Vorgängersystems.

Das moderne, erweiterte HPC-System besteht aus mehr als 840 SMP-Knoten mit 64-bit Xeon Prozessoren von Intel. Es dient der Grundversorgung der Universitäten des Landes Baden-Württemberg mit Rechenleistung und kann von den Mitarbeiterinnen und Mitarbeitern aller Universitäten in Baden-Württemberg unentgeltlich genutzt werden.

Die Zugangsberechtigung zu diesem System regelt jede Landesuniversität für ihre Mitarbeiter/innen selbst. Nutzer, welche derzeit Zugang zum bwUniCluster 1 haben, werden automatisch auch Zugang zum bwUniCluster 2.0 haben. Die Beantragung neuer Entitlements oder eine Neuregistrierung sind nicht nötig.

Weitere Informationen:

Technische Beschreibung bwUniCluster 2.0

Details zu Registrierung und Zugang: wiki.bwhpc.de/e/bwUniCluster_2.0

Ab Herbst 2020 stellt das KIT die erste Aufbaustufe eines neuen Supercomputers für viele Fachgebiete bereit. Dieser wird im Sommer 2021 der Wissenschaft übergeben. Der nun unterzeichnete Liefervertrag hat eine Größenordnung von 15 Millionen Euro.

Forschung mit Supercomputern trägt zu einer modernen und nachhaltigen Gesellschaft bei“, erklärte Professor Holger Hanselka, der Präsident des KIT. „Mit der Hilfe von Hochleistungsrechnern kommt die Forschung zu Energie, Umwelt, Mobilität und Medizin schneller zu neuen Lösungen. Damit fügt sich der HoreKa perfekt in die Strategie des KIT ein, Beiträge zu gesellschaftlichen Herausforderungen zu liefern.“

„Das Thema Höchstleistungsrechnen steht für rasante Entwicklungen. So schnell, wie sich die Spitzenleistungen der Supercomputer erhöhen, so entscheidend sind sie sowohl für Spitzenforschung als auch für innovative Produkte und Prozesse in den Schlüsselbereichen der Wirtschaft. Baden-Württemberg ist auch dank des KIT in Sachen Supercomputing europaweit führend und international konkurrenzfähig. Dabei ist es nicht nur die beeindruckende Rechenleistung der Rechner, sondern auch das geballte Methodenwissen vor Ort, das unserer computergestützten Spitzenforschung zu atemberaubenden Forschungsergebnissen verhilft“, sagte die baden-württembergische Wissenschaftsministerin Theresia Bauer.

Der neue „Hochleistungsrechner Karlsruhe“ (kurz HoreKa) wird 2021 voraussichtlich zu den zehn leistungsfähigsten Rechnern Europas gehören und eine Rechenleistung von ca. 17 PetaFLOPS erbringen – also etwa 17 Billiarden Rechenoperationen in der Sekunde, was der Leistung von mehr als 150.000 Laptops entspricht.

Das System wird Wissenschaftlerinnen und Wissenschaftlern aus ganz Deutschland zur Verfügung stehen. Vor allem in den Materialwissenschaften, den Erdsystemwissenschaften, der Energie- und Mobilitätsforschung im Ingenieurwesen, den Lebenswissenschaften, sowie der Teilchen- und Astroteilchenphysik werden Forschende dank des neuen Supercomputers ein detaillierteres Verständnis hochkomplexer natürlicher und technischer Vorgänge erlangen können. Selbstverständlich kann HoreKa bei Bedarf auch von Wissenschaftlern genutzt werden, die zum Verständnis des Virus SARS-CoV-2 forschen und damit zur Bekämpfung der Krankheit COVID-19 beitragen.

Rechnen und Speichern gehen Hand in Hand

Mit HoreKa können Forschende mehr Details in größeren Systemen betrachten, normale Simulationen also zu sogenannten Multiskalen-Simulationen ausweiten. „Klimasimulationen und Erdsystemmodelle etwa werden immer feinere Auflösungen und damit einen höheren Detailgrad erreichen“, erklärt Professor Martin Frank, Direktor des Scientific Computing Center (SCC) des KIT. „Doch neben der reinen Rechenleistung steigen auch die Anforderungen an die Dateisysteme immer weiter, sowohl was Kapazität als auch Latenz angeht. Mit einem datenhungrigen System wie HoreKa setzen wir konsequent die strategische Ausrichtung des SCC auf datenintensives Rechnen fort.“

„Es gibt derzeit sehr diverse technische Entwicklungen auf dem Hardware-Markt“, so Dr. Jennifer Schröter, die Leiterin des Bereichs High Performance Computing am SCC. „Unsere technischen Anforderunen waren anspruchsvoll, aber das Ausschreibungsverfahren war bewusst technologieoffen gehalten, um das Knowhow der Bieter einzufordern und das leistungsfähigste Gesamtsystem zu erhalten.“

Zwei innovative Chiptechnologien – ein Hochleistungssystem

Herausgekommen ist ein innovatives Hybrid-System mit fast 60.000 Intel Xeon Scalable Prozessorkernen der nächsten Generation und mehr als 220 Terabyte Hauptspeicher sowie 740 NVDIA A100 Tensor Core GPUs der nächsten Generation. Als Kommunikationsnetzwerk kommt ein non-blocking NVIDIA Mellanox InfiniBand-HDR-Netzwerk mit 200 GBit/s pro Port zum Einsatz, als Datenablage dienen zwei parallele Spectrum-Scale-Dateisysteme mit einer Gesamtkapazität von mehr als 15 Petabyte. Die Rechnersysteme stammen von Lenovo, das Unternehmen pro-com Datensysteme GmbH aus Eislingen bei Stuttgart übernimmt als Generalunternehmer die Projektkoordination, Systemintegration, Lieferung und Kundenbetreuung.

„Wir freuen uns sehr darauf, dieses System gemeinsam mit unseren Partnern Lenovo und KIT in Betrieb nehmen und an die Benutzer übergeben zu können“, so Oliver Kill, Geschäftsführer des Unternehmens pro-com. Mit HoreKa feiert pro-com im Jahr 2020 nicht nur das 30-jährige Bestehen, sondern auch den größten Auftrag in der Firmengeschichte.

Maschinelles Lernen unterstützt menschliche Forscher

„Künstliche Intelligenz und Maschinelles Lernen können die Forschung in allen Anwendungsfeldern, also dort wo die drängenden Probleme der Menschheit gelöst werden, auf die Überholspur setzen“, so Marc Hamilton, Vice President Solutions Architecture and Engineering bei NVIDIA. „NVIDIA A100 Tensor Core GPUs unterstützen diese Forschung, und gemeinsam mit der NVIDIA Mellanox InfiniBand-Technologie wird der neue Supercomputer des KIT die Forschung in einem breiten Spektrum von Anwendungen deutlich beschleunigen“.

Ein zentraler Gesichtspunkt bei der Auslegung des Systems waren auch die enormen Datenmengen, welche bei wissenschaftlichen Forschungsprojekten anfallen. Je nach Anwendung können von einer einzigen Simulation mehrere Hundert Terabyte an Daten erzeugt werden. Um mit den wachsenden Datenmengen Schritt zu halten, liefern die Rechenknoten, das InfiniBand-Netzwerk und die parallelen Dateisysteme von HoreKa im Vergleich zum Vorgängersystem ForHLR jeweils einen bis zu vier Mal höheren Speicherdurchsatz.

Eine mehrstufige Datenhaltung soll zusätzlich die Weiterverarbeitung auf externen Speichersystemen mit hohem Durchsatz garantieren. HoreKa ist auch mit bis zu 45 GByte/s Datenrate an die „Large Scale Data Facility“ (LSDF) des SCC angebunden, die seit 2010 eine moderne Infrastruktur für die Speicherung, Verwaltung, Archivierung und Analyse von Forschungsdaten bietet.

Preisgekrönte Energieeffizienz

HoreKa wird vollständig im 2015 für den Vorgänger ForHLR neu errichteten Rechnergebäude auf dem Campus Nord des KIT untergebracht. Das preisgekrönte, energieeffiziente Heißwasser-Kühlkonzept basierend auf der Lenovo Neptune Direct Water Cooling (DWC) Technologie wird mit dem neuen System fortgeführt.

Den Name HoreKa wählten die Mitarbeiterinnen und Mitarbeiter des SCC in Anlehnung an „GridKa“, dem „Grid Computing Centre Karlsruhe“. Dieses befindet sich ebenfalls am SCC und stellt seit mehr als 15 Jahren erfolgreich Datenspeicher und Analysekapazitäten für Großexperimente auf der ganzen Welt bereit, darunter auch den Large Hadron Collider (LHC) am CERN in der Schweiz. Zu den größten Erfolgen von GridKa gehört die Beteiligung bei der Entdeckung des Higgs-Teilchens im Juli 2012. GridKa ist das größte und leistungsfähigste Zentrum seiner Art.

Mehr Information zu HoreKa:

https://www.scc.kit.edu/dienste/horeka.php

Mehr Information zu COVID-19-Forschung am KIT:

https://www.kit.edu/kit/corona-pandemie-forschung-und-hilfsaktivitaeten-am-kit.php

https://www.scc.kit.edu/ueberuns/13531.php

Mit dem bwUniCluster 2.0 betreibt das KIT einen zweiten Supercomputer im Landesdienst:

https://www.scc.kit.edu/dienste/bwUniCluster_2.0.php

Zur KIT-Presseinformation: www.kit.edu/kit/pi_2020_035_neuer-supercomputer-fur-das-kit.php

Achim Grindler

Ressourcen des Grid Computing Centre Karlsruhe und die HPC-Systeme des KIT unterstützen verteilte Rechenprojekte Folding@Home und Rosetta@home, mit deren Hilfe das Verständnis von Proteinen, u.a. des SARS-CoV-2 Virus, verbessert werden soll.

Seit Ende März unterstützen Rechner des Grid Computing Centre Karlsruhe (GridKa) und die HPC-Systeme des KIT die verteilten Rechenprojekte Folding@Home und Rosetta@home, um z.B. das Verständnis der Proteine des SARS-CoV-2 Virus zu verbessern.

In enger Zusammenarbeit mit dem Institut für Experimentelle Teilchenphysik (ETP) am KIT wurden die CPU-Ressourcen von GridKa in das Cobald/Tardis-System eingebunden, mit dem sonst die opportunistische Bereitstellung von Ressourcen für die Forschung in der Hochenergiephysik dynamisch verwaltet wird. Bis zu 10.000 logische CPU-Kerne von GridKa werden jetzt für die Covid-19-Forschung zur Verfügung gestellt.

Die Abteilung Scientific Computing and Simulation (SCS) hat kürzlich das neue HPC-System bwUniCluster 2.0+GFB-HPC in Betrieb genommen. Folding@Home konnte hier als nützliches Beispiel für einen sogenannten "Burn-in"-Prozess und die opportunistische Bereitstellung von Ressourcen, welche sonst aufgrund der in einem HPC-System nötigen Ablaufplanung zeitweise nicht genutzt würden, dienen. Neben den CPU-Ressourcen werden auch bis zu 132 energieeffiziente GPU-Beschleuniger des Typs NVIDIA Tesla V100 in die Berechnungen eingebunden.

Die Teams "KIT-ETP" mit GridKa und "KIT-SCS" belegt bereits Ränge unter den ersten 1000 der mehr als 250.000 Teams von Folding@Home.

Kurzfristig werden diese Ressourcen außerdem dem WeNMR-Projekt zur Verfügung gestellt. Über das dort betriebene HADDOCK-Portal können einzelne Forschungsgruppen nun auch GridKa-Ressourcen für Berechnungen zur Bekämpfung von Covid-19 in Anspruch nehmen.

Kontakt SCS: Jennifer Schröter

Kontakt GridKa: Andreas Petzold

Achim Grindler

Mitte April 2020 wird das HPC-System "Forschungshochleistungsrechner Phase I" (kurz ForHLR I) nach mehr als fünfjähriger Betriebszeit abgeschaltet.

Das HPC-System "Forschungshochleistungsrechner Phase I" (kurz ForHLR I) wird nach mehr als fünfjähriger Betriebszeit am 14.04.2020 endgültig abgeschaltet und steht danach nicht mehr zu Verfügung.

Die Dateisysteme des ForHLR I bleiben noch bis zum 12.05.2020 in Betrieb, danach werden diese ebenfalls abgeschaltet und deren Inhalte gelöscht. Eine automatische Migration der Daten auf andere Speichersysteme wird nicht erfolgen, diese muss von den Nutzern selbst durchgeführt werden.

Um diese Migration zu ermöglichen, bleiben die Login- und Data-Mover-Knoten des ehemaligen Clusters ebenfalls bis zum 12.05.2020 in Betrieb.

Als Ersatzsysteme kommen der Forschungshochleistungsrechner II (ForHLR II), der bwUniCluster 2.0+GFB oder die innerhalb der bwHPC-Initiative betriebenen bwForCluster in Frage.

Das SCC bittet um rechtzeitige Beantragung eventuell benötigter Zugriffsrechte und - je nach System - um die Einreichung von Anträgen auf Rechenzeit.