Konfiguration des ForHLR II

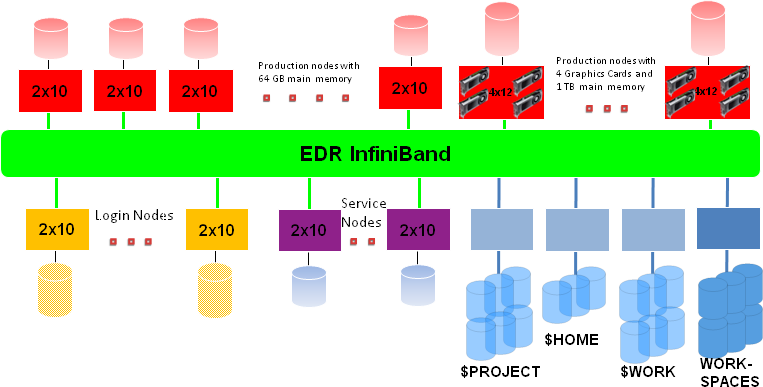

Der Forschungshochleistungsrechner ForHLR II beinhaltete

- 5 Login-Knoten mit jeweils 20 Cores mit 256 GB Hauptspeicher pro Knoten,

- 1152 "dünne" Rechenknoten mit jeweils 20 Cores mit einer theoretischen Spitzenleistung von 832 GFLOPS (bei 2,6 GHz) und 64 GB Hauptspeicher pro Knoten,

- 21 "fette" Renderingknoten mit jeweils 48 Cores mit 4 NVIDIA GeForce GTX980 Ti Grafikkarten pro Knoten und 1 TB Hauptspeicher pro Knoten

- und als Verbindungsnetzwerk ein InfiniBand 4X EDR Interconnect.

Der ForHLR II war ein massiv paralleler Parallelrechner mit insgesamt 1186 Knoten, wovon 8 Knoten Service-Knoten waren. Dabei sind die Fileserver-Knoten nicht mitgezählt. Alle Knoten - bis auf die "fetten" Renderingknoten - hatten eine Grundtaktfrequenz von 2,6 GHz (max. 3,3 GHz). Die Renderingknoten hatten eine Grundtaktfrequenz von 2,1 GHz (max. 2,7 GHz). Alle Knoten besassen lokalen Speicher, lokale Platten und Netzwerkadapter. Ein einzelner "dünner" Rechenknoten hatte eine theoretische Spitzenleistung von 832 GFLOPS, ein einzelner "fetter" Renderingknoten eine theoretische Spitzenleistung von 1613 GFLOPS (jeweils bei Grundtaktfrequenz), so dass sich für das Gesamtsystem ca. 1 PFLOPS an theoretischer Spitzenleistung ergab. Der Hauptspeicher über alle Rechenknoten hinweg betrug 95 TB. Alle Knoten waren durch ein InfiniBand 4X EDR Interconnect miteinander verbunden.

Das Basisbetriebssystem auf jedem Knoten war ein Red Hat Enterprise Linux (RHEL) 7.x. Als Managementsoftware für den Cluster diente KITE; KITE ist eine offene Umgebung für den Betrieb heterogener Rechencluster.

Als globales Dateisystem war das skalierbare, parallele Dateisystem Lustre über ein separates InfiniBand Netzwerk angebunden. Durch die Nutzung mehrerer Lustre Object Storage Target (OST) Server und Meta Data Server (MDS) war sowohl eine hohe Skalierbarkeit als auch eine Redundanz beim Ausfall einzelner Server erreicht worden. Nach dem Login befanden Sie sich im PROJECT-Verzeichnis, das gleichzeitig auch das HOME-Verzeichnis diente. In diesem stand Ihrem Projekt der über den Lenkungsausschuss bewilligte Plattenplatz zur Verfügung. Im WORK-Verzeichnis und in den Workspaces standen 4,2 PB an Plattenplatz zur Verfügung. Daneben war jeder Knoten des Clusters mit lokalen SSD's für temporäre Daten ausgestattet.

Detaillierte Kurzbeschreibung der Knoten:

- 5 20-Wege (Login-)Knoten mit jeweils 2 Deca-Core Intel Xeon E5-2660 v3 Prozessoren mit einer Grundtaktfrequenz von 2,6 GHz (max. Turbo-Taktfrequenz 3,3 GHz), 256 GB Hauptspeicher und 480 GB lokalem SSD,

- 1152 20-Wege (Rechen-)Knoten mit jeweils 2 Deca-Core Intel Xeon E5-2660 v3 Prozessoren (Haswell) mit einer Grundtaktfrequenz von 2,6 GHz (max. Turbo-Taktfrequenz 3,3 GHz), 64 GB Hauptspeicher und 480 GB lokalem SSD,

- 21 48-Wege (Rendering-)Knoten mit jeweils 4 12-Core Intel Xeon E7-4830 v3 Prozessoren (Haswell) mit einer Grundttaktfrequenz von 2,1 GHz (max. Turbo-Taktfrequenz 2,7 GHz) und 4 NVIDIA GeForce GTX980 Ti Grafikkarten, 1 TB Hauptspeicher und 4x960 GB lokalem SSD und

- 8 20-Wege Service-Knoten mit jeweils 2 Deca-Core Intel Xeon E5-2660 v3 Prozessoren mit einer Grundtaktfrequenz von 2,6 GHz und 64 GB Hauptspeicher.

Ein einzelner Deca-Core Prozessor (Haswell) hat 25 MB L3-Cache und betreibt den System Bus mit 2133 MHz, wobei jeder einzelne Core des Haswell Prozessors 64 KB L1-Cache und 256 KB L2-Cache hat.

Zugriff auf den ForHLR II für Projektbeteiligte

Nur sichere Verfahren wie secure shell (ssh) und die zugehörige secure copy (scp) waren erlaubt beim Einloggen bzw. beim Kopieren von Daten von und zum ForHLR II. Die Mechanismen telnet, rsh sowie weitere r-Kommandos waren aus Sicherheitsgründen abgeschaltet.